Сортировка кучей, пирамидальная сортировка (англ. Heapsort) — алгоритм сортировки, использующий структуру данных двоичная куча. Это неустойчивый алгоритм сортировки с временем работы , где — количество элементов для сортировки, и использующий дополнительной памяти.

Содержание

- 1 Алгоритм

- 2 Реализация

- 3 Сложность

- 4 Пример

- 5 JSort

- 5.1 Алгоритм

- 5.2 Сложность

- 5.3 Пример

- 5.4 См. также

- 5.5 Источники информации

Алгоритм

Необходимо отсортировать массив , размером . Построим на базе этого массива за кучу для максимума. Так как максимальный элемент находится в корне, то если поменять его местами с , он встанет на своё место. Далее вызовем процедуру , предварительно уменьшив на . Она за просеет на нужное место и сформирует новую кучу (так как мы уменьшили её размер, то куча располагается с по , а элемент находится на своём месте). Повторим эту процедуру для новой кучи, только корень будет менять местами не с , а с . Делая аналогичные действия, пока не станет равен , мы будем ставить наибольшее из оставшихся чисел в конец не отсортированной части. Очевидно, что таким образом, мы получим отсортированный массив.

Реализация

- — массив, который необходимо отсортировать

- — количество элементов в нём

- — процедура, которая строит из передаваемого массива кучу для максимума в этом же массиве

- — процедура, которая просеивает вниз элемент в куче из элементов, находящихся в начале массива

fun heapSort(A : list <T>):

buildHeap(A)

heapSize = A.size

for i = 0 to n - 1

swap(A[0], A[n - 1 - i])

heapSize--

siftDown(A, 0, heapSize)

Сложность

Операция работает за . Всего цикл выполняется раз. Таким образом сложность сортировки кучей является .

Достоинства:

- худшее время работы — ,

- требует дополнительной памяти.

Недостатки:

- неустойчивая,

- на почти отсортированных данных работает столь же долго, как и на хаотических данных.

Пример

|

|

|

|

|

|

|

|

Пусть дана последовательность из элементов .

| Массив | Описание шага |

|---|---|

| 5 3 4 1 2 | Строим кучу из исходного массива |

| Первый проход | |

| 2 3 4 1 5 | Меняем местами первый и последний элементы |

| 4 3 2 1 5 | Строим кучу из первых четырёх элементов |

| Второй проход | |

| 1 3 2 4 5 | Меняем местами первый и четвёртый элементы |

| 3 1 2 4 5 | Строим кучу из первых трёх элементов |

| Третий проход | |

| 2 1 3 4 5 | Меняем местами первый и третий элементы |

| 2 1 3 4 5 | Строим кучу из двух элементов |

| Четвёртый проход | |

| 1 2 3 4 5 | Меняем местами первый и второй элементы |

| 1 2 3 4 5 | Массив отсортирован |

JSort

JSort является модификацией сортировки кучей, которую придумал Джейсон Моррисон (Jason Morrison).

Алгоритм частично упорядочивает массив, строя на нём два раза кучу: один раз передвигая меньшие элементы влево, второй раз передвигая большие элементы вправо. Затем к массиву применяется

сортировка вставками, которая при почти отсортированных данных работает за .

Достоинства:

- В отличие от сортировки кучей, на почти отсортированных массивах работает быстрее, чем на случайных.

- В силу использования сортировки вставками, которая просматривает элементы последовательно, использование кэша гораздо эффективнее.

Недостатки:

- На длинных массивах, возникают плохо отсортированные последовательности в середине массива, что приводит к ухудшению работы сортировки вставками.

Алгоритм

Построим кучу для минимума на этом массиве.

Тогда наименьший элемент окажется на первой позиции, а левая часть массива окажется почти отсортированной, так как ей будут соответствовать верхние узлы кучи.

Теперь построим на этом же массиве кучу так, чтобы немного упорядочить правую часть массива. Эта куча должна быть кучей для максимума и быть «зеркальной» к массиву, то есть чтобы её корень соответствовал последнему элементу массива.

К получившемуся массиву применим сортировку вставками.

Сложность

Построение кучи занимает . Почти упорядоченный массив сортировка вставками может отсортировать , но в худшем случае за .

Таким образом, наихудшая оценка Jsort — .

Пример

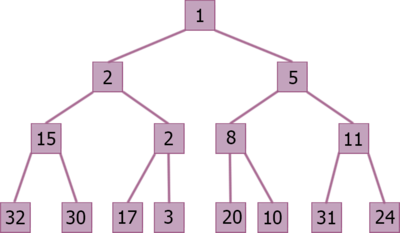

Рассмотрим, массив =

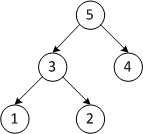

Построим на этом массиве кучу для минимума:

Массив выглядит следующим образом:

Заметим, что начало почти упорядочено, что хорошо скажется на использовании сортировки вставками.

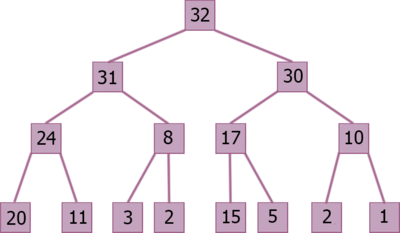

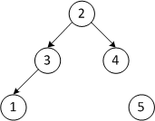

Построим теперь зеркальную кучу для максимума на этом же массиве.

Массив будет выглядеть следующим образом:

Теперь и конец массива выглядит упорядоченным, применим сортировку вставками и получим отсортированный массив.

См. также

- Сортировка слиянием

- Быстрая сортировка

- Теорема о нижней оценке для сортировки сравнениями

Источники информации

- Кормен Т., Лейзерсон Ч., Ривест Р., Штайн К. Алгоритмы: построение и анализ, 2-е издание. Издательский дом «Вильямс», 2005. ISBN 5-8459-0857-4

- Wikipedia — Heapsort

- Wikipedia — JSort

- Хабрахабр — Описание сортировки кучей и JSort

- Википедия — Пирамидальная сортировка

- 1. Что такое бинарное дерево? Какие виды бинарных деревьев существуют?

- 2. Как создать полное бинарное дерево из несортированного списка (массива)?

- 3. Связь между индексами массива и элементами дерева

- 4. Что такое структура данных кучи?

- 5. Как выстроить дерево

- 6. Сборка убывающей кучи

- 7. Процедуры для Heapsort

- 8. Представление

- 9. Применение сортировки кучей

- 10. Реализация сортировки кучи на разных языках программирования

Сортировка кучей — популярный и эффективный алгоритм сортировки в компьютерном программировании. Чтобы научиться писать алгоритм сортировки кучей, требуется знание двух типов структур данных — массивов и деревьев.

Например, начальный набор чисел, которые мы хотим отсортировать, хранится в массиве [10, 3, 76, 34, 23, 32], и после сортировки мы получаем отсортированный массив [3,10,23,32,34,76].

Сортировка кучей работает путем визуализации элементов массива как особого вида полного двоичного дерева, называемого кучей.

Что такое бинарное дерево? Какие виды бинарных деревьев существуют?

Бинарное дерево

— это структура данных дерева, в которой каждый родительский узел может иметь не более двух дочерних элементов.

Полное бинарное дерево

— это особый тип бинарного дерева, в котором у каждого родительского узла есть два или нет дочерних элементов.

Идеальное бинарное дерево

похоже на полное бинарное дерево, но с двумя основными отличиями:

- Каждый уровень должен быть полностью заполнен.

- Все элементы листа должны наклоняться влево.

Примечание: Последний элемент может не иметь правильного брата, то есть идеальное бинарное дерево не обязательно должно быть полным бинарным деревом.

Как создать полное бинарное дерево из несортированного списка (массива)?

- Выберите первый элемент списка, чтобы он быть корневым узлом. (Первый уровень — 1 элемент).

- Поместите второй элемент в качестве левого дочернего элемента корневого узла, а третий элемент — в качестве правого дочернего элемента. (Второй уровень — 2 элемента).

- Поместите следующие два элемента в качестве дочерних элементов левого узла второго уровня. Снова, поместите следующие два элемента как дочерние элементы правого узла второго уровня (3-й уровень — 4 элемента).

- Продолжайте повторять, пока не дойдете до последнего элемента.

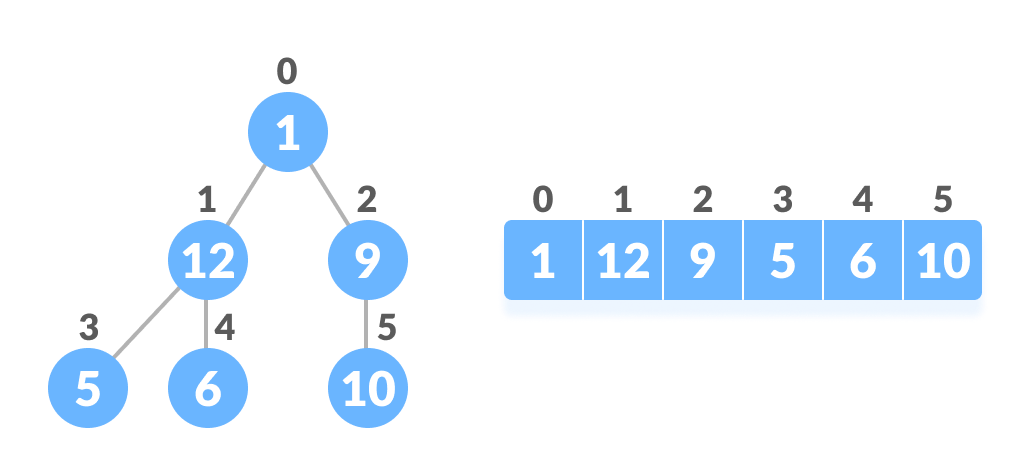

Связь между индексами массива и элементами дерева

Полное бинарное дерево обладает интересным свойством, которое мы можем использовать для поиска дочерних элементов и родителей любого узла.

Если индекс любого элемента в массиве равен i, элемент в индексе 2i + 1 станет левым потомком, а элемент в индексе 2i + 2 станет правым потомком. Кроме того, родительский элемент любого элемента с индексом i задается нижней границей (i-1) / 2.

Проверим это:

Left child of 1 (index 0) = element in (2*0+1) index = element in 1 index = 12 Right child of 1 = element in (2*0+2) index = element in 2 index = 9 Similarly, Left child of 12 (index 1) = element in (2*1+1) index = element in 3 index = 5 Right child of 12 = element in (2*1+2) index = element in 4 index = 6Также подтвердим, что правила верны для нахождения родителя любого узла:

Parent of 9 (position 2) = (2-1)/2 = ½ = 0.5 ~ 0 index = 1 Parent of 12 (position 1) = (1-1)/2 = 0 index = 1Понимание этого сопоставления индексов массива с позициями дерева имеет решающее значение для понимания того, как работает структура данных кучей и как она используется для реализации сортировки кучей.

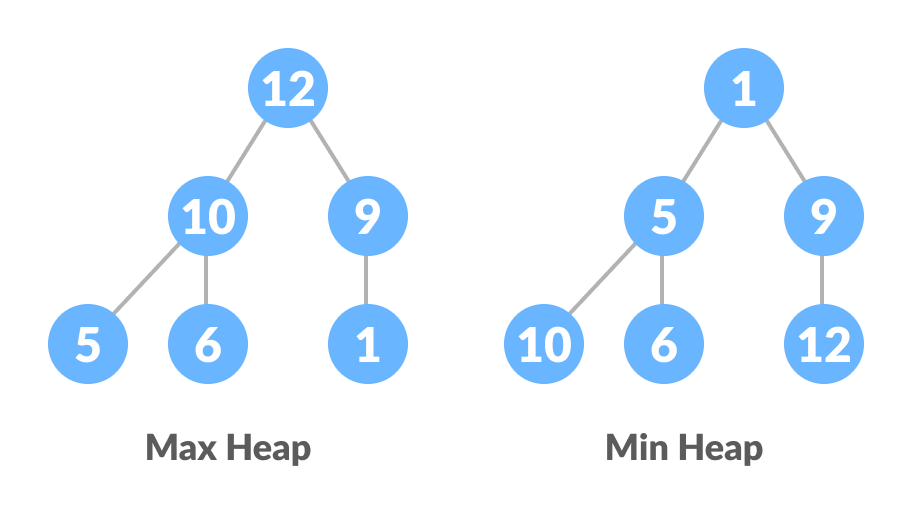

Что такое структура данных кучи?

Куча — это специальная древовидная структура данных. Говорят, что двоичное дерево следует структуре данных кучи, если

- это полное бинарное дерево;

- все узлы в дереве следуют тому свойству, что они больше своих потомков, то есть самый большой элемент находится в корне, и оба его потомка меньше, чем корень, и так далее. Такая куча называется убывающая куча (Max-Heap). Если вместо этого все узлы меньше своих потомков, это называется возрастающая куча (Min-Heap).

Слева на рисунке убывающая куча, справа — возрастающая куча.

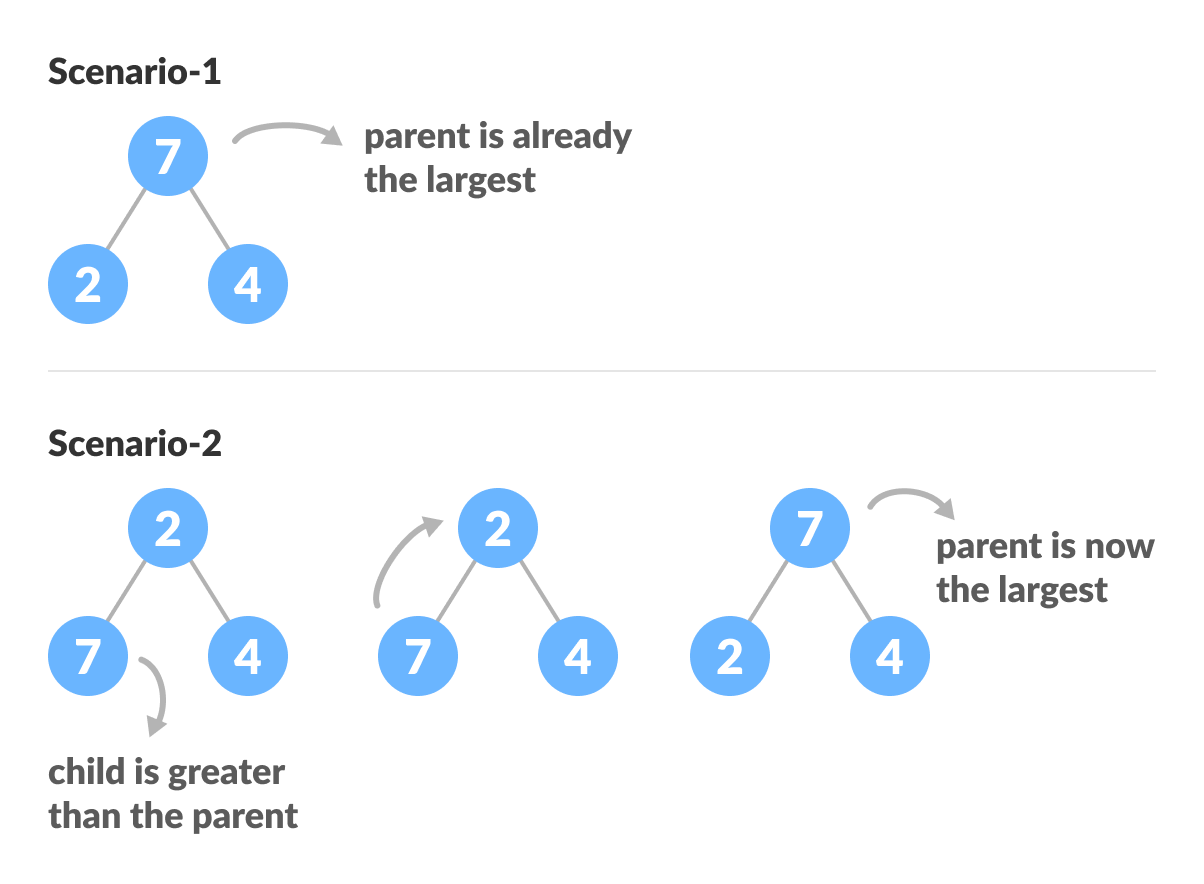

Как выстроить дерево

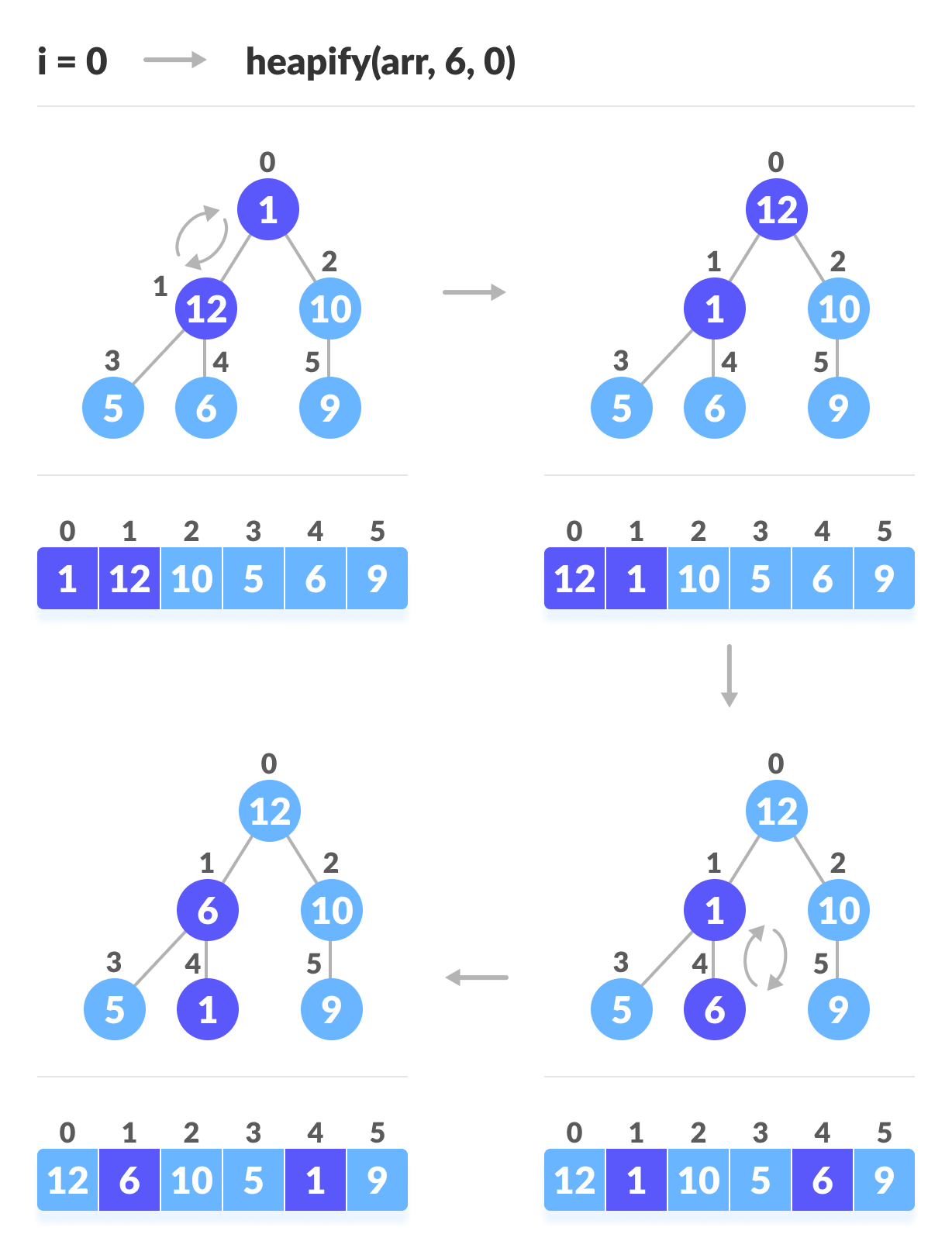

Начиная с идеального бинарного дерева, мы можем изменить его, чтобы оно стало убывающим, запустив функцию heapify для всех неконечных элементов кучи.

Поскольку heapfiy использует рекурсию, это может быть трудно для понимания. Итак, давайте сначала подумаем о том, как бы вы сложили дерево из трех элементов.

heapify(array) Root = array[0] Largest = largest( array[0] , array [2*0 + 1]. array[2*0+2]) if(Root != Largest) Swap(Root, Largest)

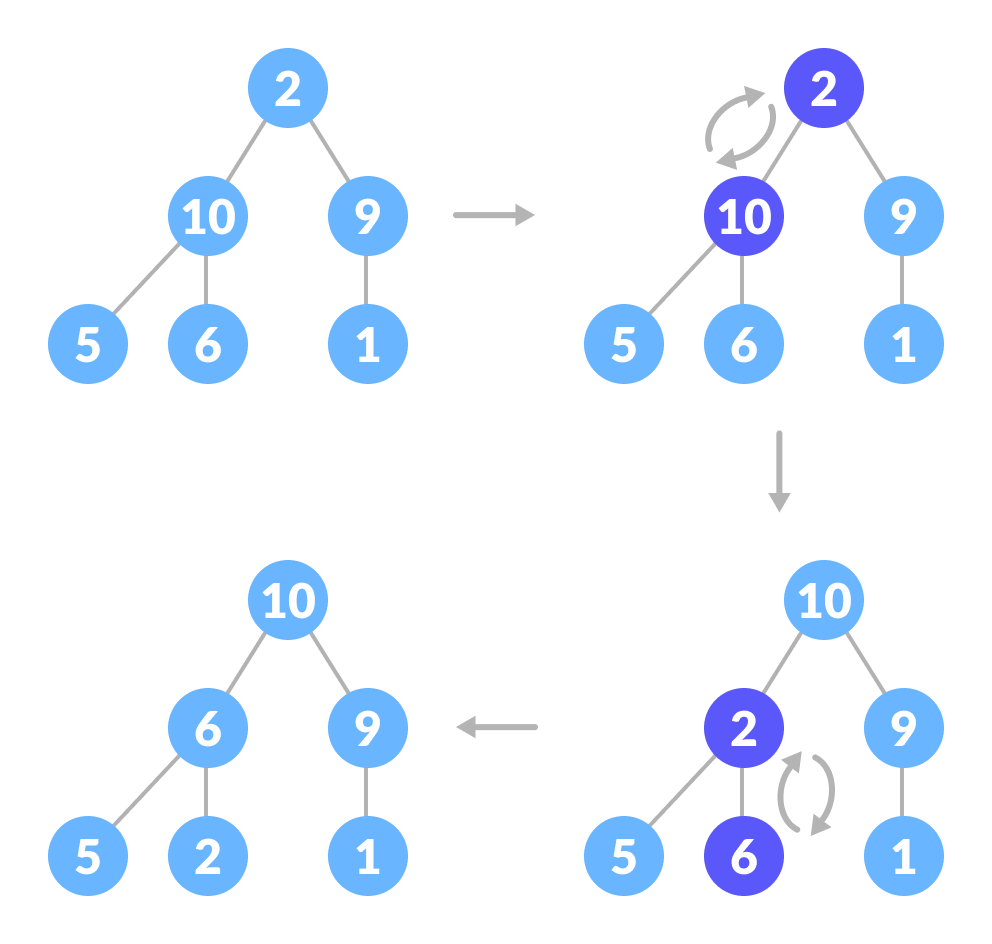

В приведенном выше примере показаны два сценария — один, в котором корень является самым большим элементом, и нам не нужно ничего делать. И еще один, в котором корень имеет дочерний элемент большего размера, и нам нужно было поменять их местами, чтобы сохранить свойство убывающей кучи.

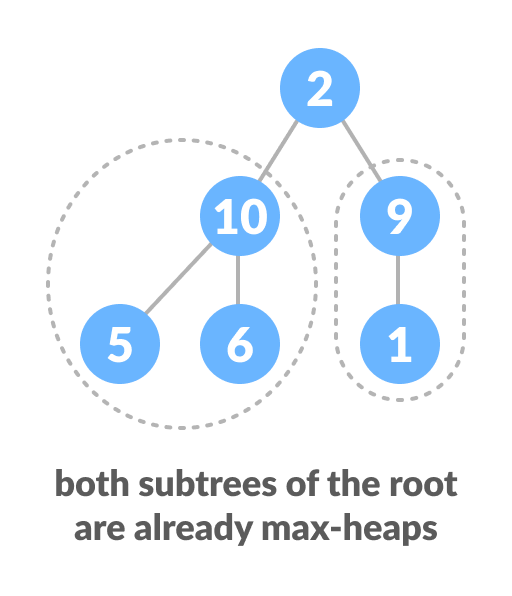

Если вы раньше работали с рекурсивными алгоритмами, то вы поняли, что это должен быть базовый случай.Теперь давайте подумаем о другом сценарии, в котором существует более одного уровня.

На рисунке оба поддерева корневого элемента второго уровня уже являются

убывающими кучами.

Верхний элемент не подходит под убывающую кучу, но все поддеревья являются убывабщими.

Чтобы сохранить свойство убывания для всего дерева, нам нужно будет «протолкнуть» родителя вниз, пока он не достигнет своей правильной позиции.

Таким образом, чтобы сохранить свойство убывания в дереве, где оба поддеревья являются убывающими, нам нужно многократно запускать heapify для корневого элемента, пока он не станет больше, чем его дочерние элементы, или он не станет листовым узлом.

Мы можем объединить оба эти условия в одну функцию heapify следующим образом:

void heapify(int arr[], int n, int i) { int largest = i; int l = 2*i + 1; int r = 2*i + 2; if (l < n && arr[l] > arr[largest]) largest = l; if (right < n && arr[r] > arr[largest]) largest = r; if (largest != i) { swap(arr[i], arr[largest]); // Recursively heapify the affected sub-tree heapify(arr, n, largest); } }Эта функция работает как для базового случая, так и для дерева любого размера. Таким образом, мы можем переместить корневой элемент в правильное положение, чтобы поддерживать статус убывающей кучи для любого размера дерева, пока поддеревья являются убывающими.

Сборка убывающей кучи

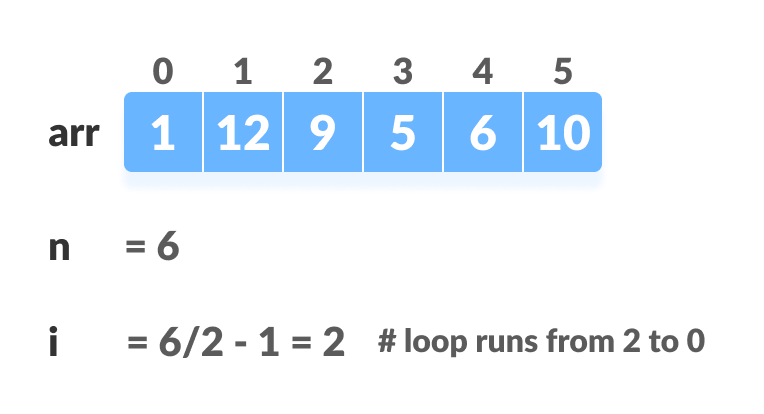

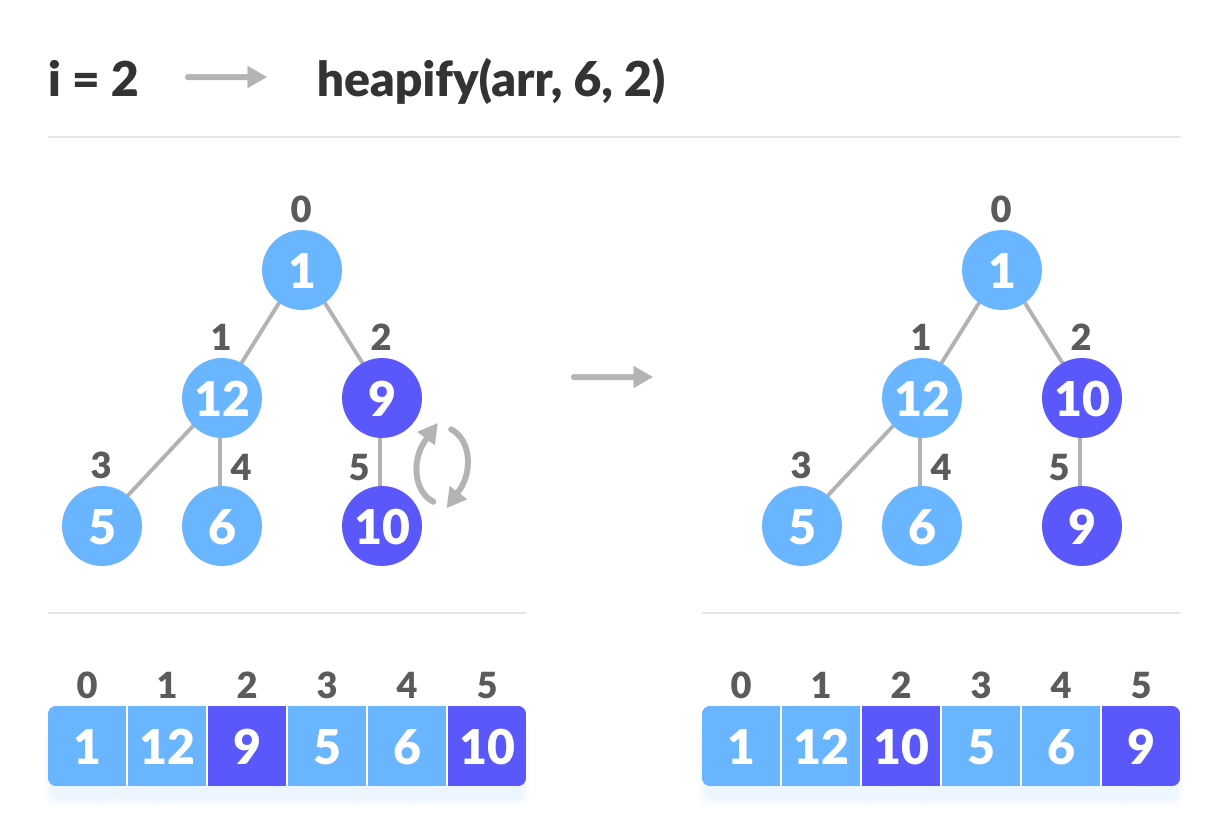

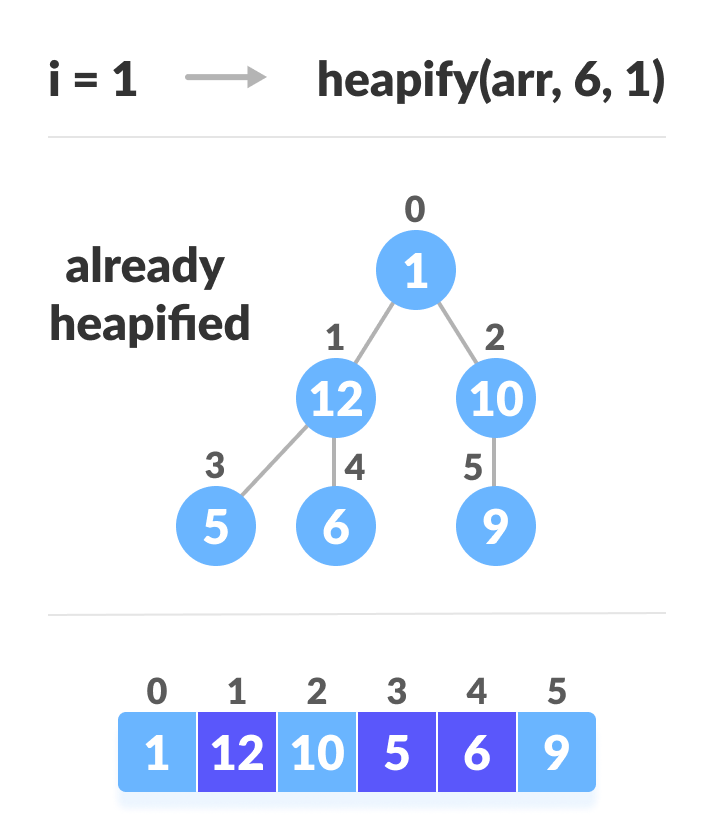

Чтобы собрать убывающую кучу из любого дерева, мы можем начать выстраивать каждое поддерево снизу вверх и получить убывающую кучу после применения функции ко всем элементам, включая корневой элемент.

В случае полного дерева первый индекс неконечного узла определяется как n / 2 — 1. Все остальные узлы после этого являются листовыми узлами и, следовательно, не нуждаются в куче.

Мы можем выстроить убывающую кучу так:

// Build heap (rearrange array) for (int i = n / 2 - 1; i >= 0; i--) heapify(arr, n, i);

Как показано на диаграмме выше, мы начинаем с кучи самых маленьких деревьев и постепенно продвигаемся вверх, пока не достигнем корневого элемента.

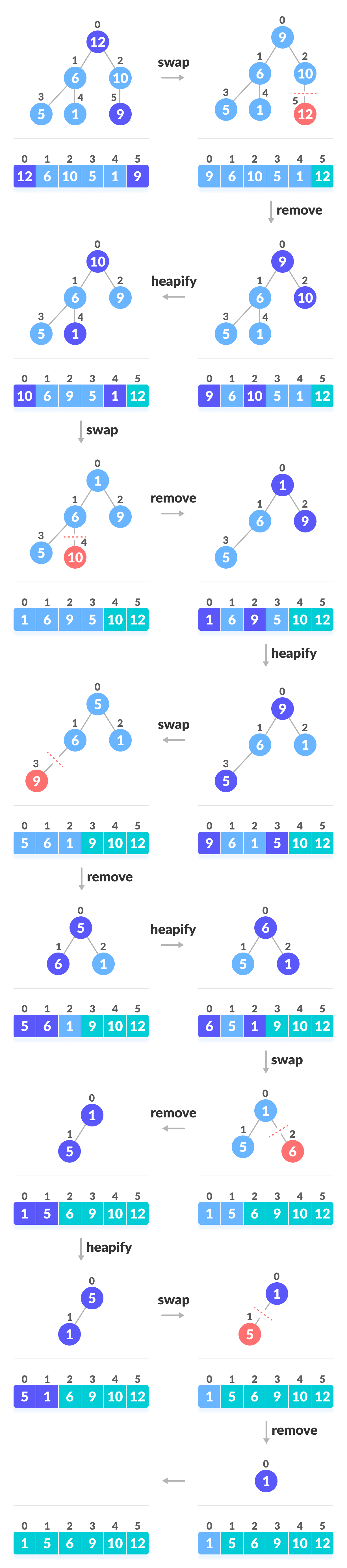

Процедуры для Heapsort

- Поскольку дерево удовлетворяет свойству убывающей, самый большой элемент сохраняется в корневом узле.

- Удалите корневой элемент и поместите в конец массива (n-я позиция). Поместите последний элемент дерева (кучу) в свободное место.

- Уменьшите размер кучи на 1 и снова укрупните корневой элемент, чтобы у вас был самый большой элемент в корне.

- Процесс повторяется до тех пор, пока все элементы списка не будут отсортированы.

Код выглядит так:

for (int i=n-1; i>=0; i--) { // Переместить текущий корень в конец swap(arr[0], arr[i]); // вызовите максимальный heapify на уменьшенной куче heapify(arr, i, 0); }Представление

Сортировка кучи имеет O (nlogn) временные сложности для всех случаев (лучший случай, средний случай и худший случай). В чем же причина? Высота полного бинарного дерева, содержащего n элементов, равна log (n).

Как мы видели ранее, чтобы полностью накапливать элемент, чьи поддеревья уже являются убывабщими кучами, нам нужно продолжать сравнивать элемент с его левым и правым потомками и толкать его вниз, пока он не достигнет точки, где оба его потомка меньше его.

В худшем случае нам потребуется переместить элемент из корневого узла в конечный узел, выполнив несколько сравнений и обменов log (n).

На этапе build_max_heap мы делаем это для n / 2 элементов, поэтому сложность шага build_heap в наихудшем случае равна n / 2 * log (n) ~ nlogn.

На этапе сортировки мы обмениваем корневой элемент с последним элементом и подкачиваем корневой элемент. Для каждого элемента это снова занимает большое время, поскольку нам, возможно, придется перенести этот элемент от корня до листа. Поскольку мы повторяем операцию n раз, шаг heap_sort также nlogn.

Кроме того, поскольку шаги build_max_heap и heap_sort выполняются один за другим, алгоритмическая сложность не умножается и остается в порядке nlogn.

Также выполняется сортировка в O (1) пространстве сложности. По сравнению с быстрой сортировкой, в худшем случае (O (nlogn)). Быстрая сортировка имеет сложность O (n ^ 2) для худшего случая. Но в других случаях быстрая сортировка выполняется достаточно быстро. Introsort — это альтернатива heapsort, которая сочетает в себе quicksort и heapsort для сохранения преимуществ, таких как скорость heapsort в худшем случае и средняя скорость quicksort.

Применение сортировки кучей

Системы, связанные с безопасностью, и встроенные системы, такие как ядро Linux, используют сортировку кучей из-за верхней границы O (n log n) времени работы Heapsort и постоянной верхней границы O (1) его вспомогательного хранилища.

Хотя сортировка кучей имеет O (n log n) временную сложность даже для наихудшего случая, у нее нет больше приложений (по сравнению с другими алгоритмами сортировки, такими как быстрая сортировка, сортировка слиянием). Тем не менее, его базовая структура данных, куча, может быть эффективно использована, если мы хотим извлечь наименьший (или наибольший) из списка элементов без дополнительных затрат на сохранение оставшихся элементов в отсортированном порядке. Например, приоритетные очереди.

Реализация сортировки кучи на разных языках программирования

Реализация C ++

// C++ program for implementation of Heap Sort #include <iostream> using namespace std; void heapify(int arr[], int n, int i) { // Find largest among root, left child and right child int largest = i; int l = 2*i + 1; int r = 2*i + 2; if (l < n && arr[l] > arr[largest]) largest = l; if (right < n && arr[r] > arr[largest]) largest = r; // Swap and continue heapifying if root is not largest if (largest != i) { swap(arr[i], arr[largest]); heapify(arr, n, largest); } } // main function to do heap sort void heapSort(int arr[], int n) { // Build max heap for (int i = n / 2 - 1; i >= 0; i--) heapify(arr, n, i); // Heap sort for (int i=n-1; i>=0; i--) { swap(arr[0], arr[i]); // Heapify root element to get highest element at root again heapify(arr, i, 0); } } void printArray(int arr[], int n) { for (int i=0; i<n; ++i) cout << arr[i] << " "; cout << "n"; } int main() { int arr[] = {1,12,9,5,6,10}; int n = sizeof(arr)/sizeof(arr[0]); heapSort(arr, n); cout << "Sorted array is n"; printArray(arr, n); }

Реализация на Java

// Java program for implementation of Heap Sort public class HeapSort { public void sort(int arr[]) { int n = arr.length; // Build max heap for (int i = n / 2 - 1; i >= 0; i--) { heapify(arr, n, i); } // Heap sort for (int i=n-1; i>=0; i--) { int temp = arr[0]; arr[0] = arr[i]; arr[i] = temp; // Heapify root element heapify(arr, i, 0); } } void heapify(int arr[], int n, int i) { // Find largest among root, left child and right child int largest = i; int l = 2*i + 1; int r = 2*i + 2; if (l < n && arr[l] > arr[largest]) largest = l; if (r < n && arr[r] > arr[largest]) largest = r; // Swap and continue heapifying if root is not largest if (largest != i) { int swap = arr[i]; arr[i] = arr[largest]; arr[largest] = swap; heapify(arr, n, largest); } } static void printArray(int arr[]) { int n = arr.length; for (int i=0; i < n; ++i) System.out.print(arr[i]+" "); System.out.println(); } public static void main(String args[]) { int arr[] = {1,12,9,5,6,10}; HeapSort hs = new HeapSort(); hs.sort(arr); System.out.println("Sorted array is"); printArray(arr); } }

Реализация на Python (Python 3)

def heapify(arr, n, i): # Find largest among root and children largest = i l = 2 * i + 1 r = 2 * i + 2 if l < n and arr[i] < arr[l]: largest = l if r < n and arr[largest] < arr[r]: largest = r # If root is not largest, swap with largest and continue heapifying if largest != i: arr[i],arr[largest] = arr[largest],arr[i] heapify(arr, n, largest) def heapSort(arr): n = len(arr) # Build max heap for i in range(n, 0, -1): heapify(arr, n, i) for i in range(n-1, 0, -1): # swap arr[i], arr[0] = arr[0], arr[i] #heapify root element heapify(arr, i, 0) arr = [ 12, 11, 13, 5, 6, 7] heapSort(arr) n = len(arr) print ("Sorted array is") for i in range(n): print ("%d" %arr[i])

Перевод статьи подготовлен специально для студентов курса «Алгоритмы для разработчиков».

Пирамидальная сортировка (или сортировка кучей, HeapSort) — это метод сортировки сравнением, основанный на такой структуре данных как двоичная куча. Она похожа на сортировку выбором, где мы сначала ищем максимальный элемент и помещаем его в конец. Далее мы повторяем ту же операцию для оставшихся элементов.

Что такое двоичная куча?

Давайте сначала определим законченное двоичное дерево. Законченное двоичное дерево — это двоичное дерево, в котором каждый уровень, за исключением, возможно, последнего, имеет полный набор узлов, и все листья расположены как можно левее (Источник Википедия).

Двоичная куча — это законченное двоичное дерево, в котором элементы хранятся в особом порядке: значение в родительском узле больше (или меньше) значений в его двух дочерних узлах. Первый вариант называется max-heap, а второй — min-heap. Куча может быть представлена двоичным деревом или массивом.

Почему для двоичной кучи используется представление на основе массива ?

Поскольку двоичная куча — это законченное двоичное дерево, ее можно легко представить в виде массива, а представление на основе массива является эффективным с точки зрения расхода памяти. Если родительский узел хранится в индексе I, левый дочерний элемент может быть вычислен как 2 I + 1, а правый дочерний элемент — как 2 I + 2 (при условии, что индексирование начинается с 0).

Алгоритм пирамидальной сортировки в порядке по возрастанию:

- Постройте max-heap из входных данных.

- На данном этапе самый большой элемент хранится в корне кучи. Замените его на последний элемент кучи, а затем уменьшите ее размер на 1. Наконец, преобразуйте полученное дерево в max-heap с новым корнем.

- Повторяйте вышеуказанные шаги, пока размер кучи больше 1.

Как построить кучу?

Процедура преобразования в кучу (далее процедура heapify) может быть применена к узлу, только если его дочерние узлы уже преобразованы. Таким образом, преобразование должно выполняться снизу вверх. Давайте разберемся с помощью примера:

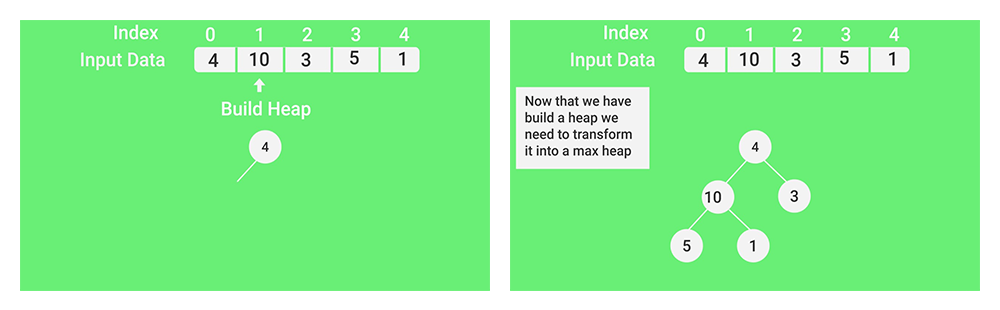

Входные данные: 4, 10, 3, 5, 1

4(0)

/

10(1) 3(2)

/

5(3) 1(4)

Числа в скобках представляют индексы в представлении данных в виде массива.

Применение процедуры heapify к индексу 1:

4(0)

/

10(1) 3(2)

/

5(3) 1(4)

Применение процедуры heapify к индексу 0:

10(0)

/

5(1) 3(2)

/

4(3) 1(4)

Процедура heapify вызывает себя рекурсивно для создания кучи сверху вниз.Рекомендация: Пожалуйста, сначала решите задачу на “PRACTICE”, прежде чем переходить к решению.

C++

// Реализация пирамидальной сортировки на C++

#include <iostream>

using namespace std;

// Процедура для преобразования в двоичную кучу поддерева с корневым узлом i, что является

// индексом в arr[]. n - размер кучи

void heapify(int arr[], int n, int i)

{

int largest = i;

// Инициализируем наибольший элемент как корень

int l = 2*i + 1; // левый = 2*i + 1

int r = 2*i + 2; // правый = 2*i + 2

// Если левый дочерний элемент больше корня

if (l < n && arr[l] > arr[largest])

largest = l;

// Если правый дочерний элемент больше, чем самый большой элемент на данный момент

if (r < n && arr[r] > arr[largest])

largest = r;

// Если самый большой элемент не корень

if (largest != i)

{

swap(arr[i], arr[largest]);

// Рекурсивно преобразуем в двоичную кучу затронутое поддерево

heapify(arr, n, largest);

}

}

// Основная функция, выполняющая пирамидальную сортировку

void heapSort(int arr[], int n)

{

// Построение кучи (перегруппируем массив)

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);

// Один за другим извлекаем элементы из кучи

for (int i=n-1; i>=0; i--)

{

// Перемещаем текущий корень в конец

swap(arr[0], arr[i]);

// вызываем процедуру heapify на уменьшенной куче

heapify(arr, i, 0);

}

}

/* Вспомогательная функция для вывода на экран массива размера n*/

void printArray(int arr[], int n)

{

for (int i=0; i<n; ++i)

cout << arr[i] << " ";

cout << "n";

}

// Управляющая программа

int main()

{

int arr[] = {12, 11, 13, 5, 6, 7};

int n = sizeof(arr)/sizeof(arr[0]);

heapSort(arr, n);

cout << "Sorted array is n";

printArray(arr, n);

}Java

// Реализация пирамидальной сортировки на Java

public class HeapSort

{

public void sort(int arr[])

{

int n = arr.length;

// Построение кучи (перегруппируем массив)

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);

// Один за другим извлекаем элементы из кучи

for (int i=n-1; i>=0; i--)

{

// Перемещаем текущий корень в конец

int temp = arr[0];

arr[0] = arr[i];

arr[i] = temp;

// Вызываем процедуру heapify на уменьшенной куче

heapify(arr, i, 0);

}

}

// Процедура для преобразования в двоичную кучу поддерева с корневым узлом i, что является

// индексом в arr[]. n - размер кучи

void heapify(int arr[], int n, int i)

{

int largest = i; // Инициализируем наибольший элемент как корень

int l = 2*i + 1; // левый = 2*i + 1

int r = 2*i + 2; // правый = 2*i + 2

// Если левый дочерний элемент больше корня

if (l < n && arr[l] > arr[largest])

largest = l;

// Если правый дочерний элемент больше, чем самый большой элемент на данный момент

if (r < n && arr[r] > arr[largest])

largest = r;

// Если самый большой элемент не корень

if (largest != i)

{

int swap = arr[i];

arr[i] = arr[largest];

arr[largest] = swap;

// Рекурсивно преобразуем в двоичную кучу затронутое поддерево

heapify(arr, n, largest);

}

}

/* Вспомогательная функция для вывода на экран массива размера n */

static void printArray(int arr[])

{

int n = arr.length;

for (int i=0; i<n; ++i)

System.out.print(arr[i]+" ");

System.out.println();

}

// Управляющая программа

public static void main(String args[])

{

int arr[] = {12, 11, 13, 5, 6, 7};

int n = arr.length;

HeapSort ob = new HeapSort();

ob.sort(arr);

System.out.println("Sorted array is");

printArray(arr);

}

}Python

# Реализация пирамидальной сортировки на Python

# Процедура для преобразования в двоичную кучу поддерева с корневым узлом i, что является индексом в arr[]. n - размер кучи

def heapify(arr, n, i):

largest = i # Initialize largest as root

l = 2 * i + 1 # left = 2*i + 1

r = 2 * i + 2 # right = 2*i + 2

# Проверяем существует ли левый дочерний элемент больший, чем корень

if l < n and arr[i] < arr[l]:

largest = l

# Проверяем существует ли правый дочерний элемент больший, чем корень

if r < n and arr[largest] < arr[r]:

largest = r

# Заменяем корень, если нужно

if largest != i:

arr[i],arr[largest] = arr[largest],arr[i] # свап

# Применяем heapify к корню.

heapify(arr, n, largest)

# Основная функция для сортировки массива заданного размера

def heapSort(arr):

n = len(arr)

# Построение max-heap.

for i in range(n, -1, -1):

heapify(arr, n, i)

# Один за другим извлекаем элементы

for i in range(n-1, 0, -1):

arr[i], arr[0] = arr[0], arr[i] # свап

heapify(arr, i, 0)

# Управляющий код для тестирования

arr = [ 12, 11, 13, 5, 6, 7]

heapSort(arr)

n = len(arr)

print ("Sorted array is")

for i in range(n):

print ("%d" %arr[i]),

# Этот код предоставил Mohit KumraC Sharp

// Реализация пирамидальной сортировки на C#

using System;

public class HeapSort

{

public void sort(int[] arr)

{

int n = arr.Length;

// Построение кучи (перегруппируем массив)

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);

// Один за другим извлекаем элементы из кучи

for (int i=n-1; i>=0; i--)

{

// Перемещаем текущий корень в конец

int temp = arr[0];

arr[0] = arr[i];

arr[i] = temp;

// вызываем процедуру heapify на уменьшенной куче

heapify(arr, i, 0);

}

}

// Процедура для преобразования в двоичную кучу поддерева с корневым узлом i, что является

// индексом в arr[]. n - размер кучи

void heapify(int[] arr, int n, int i)

{

int largest = i;

// Инициализируем наибольший элемент как корень

int l = 2*i + 1; // left = 2*i + 1

int r = 2*i + 2; // right = 2*i + 2

// Если левый дочерний элемент больше корня

if (l < n && arr[l] > arr[largest])

largest = l;

// Если правый дочерний элемент больше, чем самый большой элемент на данный момент

if (r < n && arr[r] > arr[largest])

largest = r;

// Если самый большой элемент не корень

if (largest != i)

{

int swap = arr[i];

arr[i] = arr[largest];

arr[largest] = swap;

// Рекурсивно преобразуем в двоичную кучу затронутое поддерево

heapify(arr, n, largest);

}

}

/* Вспомогательная функция для вывода на экран массива размера n */

static void printArray(int[] arr)

{

int n = arr.Length;

for (int i=0; i<n; ++i)

Console.Write(arr[i]+" ");

Console.Read();

}

//Управляющая программа

public static void Main()

{

int[] arr = {12, 11, 13, 5, 6, 7};

int n = arr.Length;

HeapSort ob = new HeapSort();

ob.sort(arr);

Console.WriteLine("Sorted array is");

printArray(arr);

}

}

//Этот код предоставил

// Akanksha Ra (Abby_akku)PHP

<?php

// Реализация пирамидальной сортировки на Php

// Процедура для преобразования в двоичную кучу поддерева с корневым узлом i, что является

// индексом в arr[]. n - размер кучи

function heapify(&$arr, $n, $i)

{

$largest = $i; // Инициализируем наибольший элемент как корень

$l = 2*$i + 1; // левый = 2*i + 1

$r = 2*$i + 2; // правый = 2*i + 2

// Если левый дочерний элемент больше корня

if ($l < $n && $arr[$l] > $arr[$largest])

$largest = $l;

//Если правый дочерний элемент больше, чем самый большой элемент на данный момент

if ($r < $n && $arr[$r] > $arr[$largest])

$largest = $r;

// Если самый большой элемент не корень

if ($largest != $i)

{

$swap = $arr[$i];

$arr[$i] = $arr[$largest];

$arr[$largest] = $swap;

// Рекурсивно преобразуем в двоичную кучу затронутое поддерево

heapify($arr, $n, $largest);

}

}

//Основная функция, выполняющая пирамидальную сортировку

function heapSort(&$arr, $n)

{

// Построение кучи (перегруппируем массив)

for ($i = $n / 2 - 1; $i >= 0; $i--)

heapify($arr, $n, $i);

//Один за другим извлекаем элементы из кучи

for ($i = $n-1; $i >= 0; $i--)

{

// Перемещаем текущий корень в конец

$temp = $arr[0];

$arr[0] = $arr[$i];

$arr[$i] = $temp;

// вызываем процедуру heapify на уменьшенной куче

heapify($arr, $i, 0);

}

}

/* Вспомогательная функция для вывода на экран массива размера n */

function printArray(&$arr, $n)

{

for ($i = 0; $i < $n; ++$i)

echo ($arr[$i]." ") ;

}

// Управляющая программа

$arr = array(12, 11, 13, 5, 6, 7);

$n = sizeof($arr)/sizeof($arr[0]);

heapSort($arr, $n);

echo 'Sorted array is ' . "n";

printArray($arr , $n);

// Этот код предоставил Shivi_Aggarwal

?>Вывод:

Отсортированный массив:

5 6 7 11 12 13Здесь предыдущий C-код для справки.

Замечания:

Пирамидальная сортировка — это вполне годный алгоритм. Его типичная реализация не стабильна, но может быть таковой сделана (см. Здесь).

Временная сложность: Временная сложность heapify — O(Logn). Временная сложность createAndBuildHeap() равна O(n), а общее время работы пирамидальной сортировки — O(nLogn).

Применения пирамидальной сортировки:

- Отсортировать почти отсортированный (или отсортированный на K позиций) массив ;

- k самых больших (или самых маленьких) элементов в массиве.

Алгоритм пирамидальной сортировки имеет ограниченное применение, потому что Quicksort (Быстрая сортировка) и Mergesort (Сортировка слиянием) на практике лучше. Тем не менее, сама структура данных кучи используется довольно часто. См. Применения структуры данных кучи

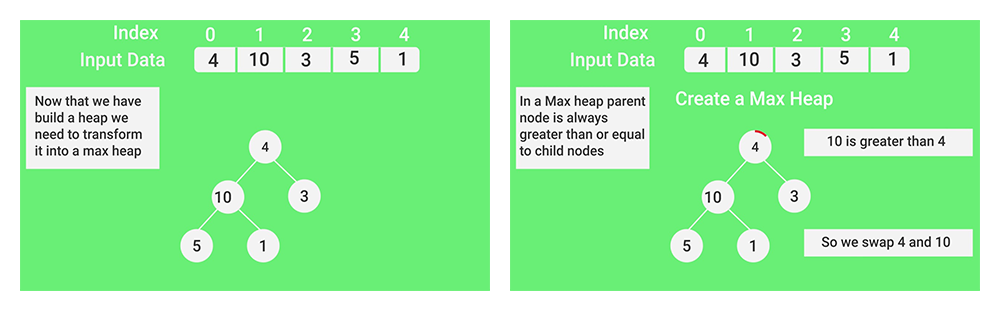

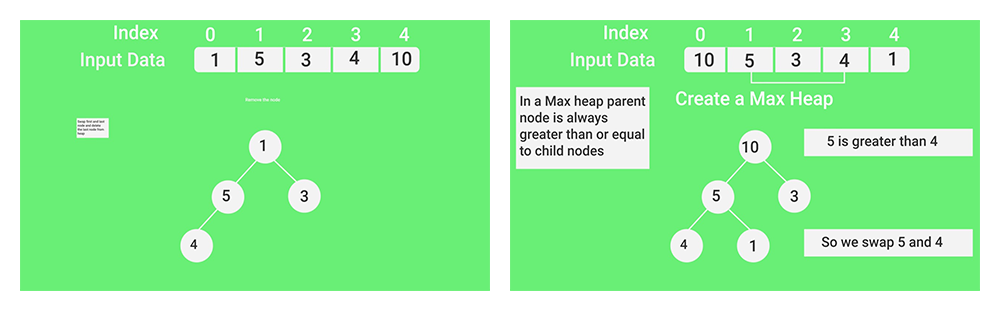

Скриншоты:

— (Теперь, когда мы построили кучу, мы должны преобразовать ее в max-heap)

— (В max-heap родительский узел всегда больше или равен по отношению к дочерним

10 больше 4. Поэтому мы меняем местами 4 и 10)

— (В max-heap родительский узел всегда больше или равен по отношению к дочерним

5 больше 4. По этому мы меняем местами 5 и 4)

— (Меняем местами первый и последний узлы и удаляем последний из кучи)

Тест по пирамидальной сортировке

Другие алгоритмы сортировки на GeeksforGeeks/GeeksQuiz:

Быстрая сортировка, Сортировка выбором, Сортировка пузырьком, Сортировка вставками, Сортировка слиянием, Пирамидальная сортировка, Поразрядная сортировка, Сортировка подсчетом, Блочная сортировка, Сортировка Шелла, Сортировка расческой, Сортировка подсчетом со списком.

Практикум по сортировке

Пожалуйста, оставляйте комментарии, если вы обнаружите что-то неправильное или вы хотите поделиться дополнительной информацией по обсуждаемой выше теме.

- Подробности

- Категория: Сортировка и поиск

Пирамидальная сортировка (англ. Heapsort, «Сортировка кучей») — алгоритм сортировки, работающий в худшем, в среднем и в лучшем случае (то есть гарантированно) за O(n log n) операций при сортировке n элементов. Количество применяемой служебной памяти не зависит от размера массива (то есть, O(1)).

Может рассматриваться как усовершенствованная сортировка пузырьком, в которой элемент всплывает (min-heap) / тонет (max-heap) по многим путям.

Необходимо отсортировать массив

![A[n - 1]](http://neerc.ifmo.ru/wiki/images/math/f/c/2/fc2868cc76a0d0e7547fbb3face8e9a1.png)

![A[0]](http://neerc.ifmo.ru/wiki/images/math/6/5/4/654231fbdf81aaea7e32bc552bf58a0b.png)

![A[0]](http://neerc.ifmo.ru/wiki/images/math/6/5/4/654231fbdf81aaea7e32bc552bf58a0b.png)

![A[n - 2]](http://neerc.ifmo.ru/wiki/images/math/5/a/7/5a72863148b487a8c30973b32027eb0f.png)

![A[n-1]](http://neerc.ifmo.ru/wiki/images/math/1/7/4/174c5d6c094683ab26f236920cfba0c2.png)

![A[n - 1]](http://neerc.ifmo.ru/wiki/images/math/f/c/2/fc2868cc76a0d0e7547fbb3face8e9a1.png)

![A[n-2]](http://neerc.ifmo.ru/wiki/images/math/3/4/d/34d7bc6f3d4794e3e848add044f324c7.png)

| Худшее время |

O(n log n) |

|---|---|

| Лучшее время |

O(n log n) |

| Среднее время |

O(n log n) |

Пусть дана последовательность из

| Массив | Описание шага |

|---|---|

| 5 3 4 1 2 | Строим кучу из исходного массива |

| Первый проход | |

| 2 3 4 1 5 | Меняем местами первый и последний элементы |

| 4 3 2 1 5 | Строим кучу из первых четырех элементов |

| Второй проход | |

| 1 3 2 4 5 | Меняем местами первый и четвертый элементы |

| 3 1 2 4 5 | Строим кучу из первых трех элементов |

| Третий проход | |

| 2 1 3 4 5 | Меняем местами первый и третий элементы |

| 2 1 3 4 5 | Строим кучу из двух элементов |

| Четвертый проход | |

| 1 2 3 4 5 | Меняем местами первый и второй элементы |

| 1 2 3 4 5 | Массив отсортирован |

Реализация алгоритма на различных языках программирования:

C

#include <stdio.h>

#define MAXL 1000

void swap (int *a, int *b)

{

int t = *a;

*a = *b;

*b = t;

}

int main()

{

int a[MAXL], n, i, sh = 0, b = 0;

scanf ("%i", &n);

for (i = 0; i < n; ++i)

scanf ("%i", &a[i]);

while (1)

{

b = 0;

for (i = 0; i < n; ++i)

{

if (i*2 + 2 + sh < n)

{

if (a[i+sh] > a[i*2 + 1 + sh] || a[i + sh] > a[i*2 + 2 + sh])

{

if (a[i*2+1+sh] < a[i*2+2+sh])

{

swap (&a[i+sh], &a[i*2+1+sh]);

b = 1;

}

else if (a[i*2+2+sh] < a[i*2+1+sh])

{

swap (&a[i+sh],&a[i*2+2+sh]);

b = 1;

}

}

}

else if (i * 2 + 1 + sh < n)

{

if (a[i+sh] > a[i*2+1+sh])

{

swap (&a[i+sh], &a[i*2+1+sh]);

b=1;

}

}

}

if (!b) sh++;

if (sh+2==n)

break;

}

for (i = 0; i < n; ++i)

printf ("%i%c", a[i], (i!=n-1)?' ':'n');

return 0;

}

C++

#include <iterator>

template< typename Iterator >

void adjust_heap( Iterator first

, typename std::iterator_traits< Iterator >::difference_type current

, typename std::iterator_traits< Iterator >::difference_type size

, typename std::iterator_traits< Iterator >::value_type tmp )

{

typedef typename std::iterator_traits< Iterator >::difference_type diff_t;

diff_t top = current, next = 2 * current + 2;

for ( ; next < size; current = next, next = 2 * next + 2 )

{

if ( *(first + next) < *(first + next - 1) )

--next;

*(first + current) = *(first + next);

}

if ( next == size )

*(first + current) = *(first + size - 1), current = size - 1;

for ( next = (current - 1) / 2;

top > current && *(first + next) < tmp;

current = next, next = (current - 1) / 2 )

{

*(first + current) = *(first + next);

}

*(first + current) = tmp;

}

template< typename Iterator >

void pop_heap( Iterator first, Iterator last)

{

typedef typename std::iterator_traits< Iterator >::value_type value_t;

value_t tmp = *--last;

*last = *first;

adjust_heap( first, 0, last - first, tmp );

}

template< typename Iterator >

void heap_sort( Iterator first, Iterator last )

{

typedef typename std::iterator_traits< Iterator >::difference_type diff_t;

for ( diff_t current = (last - first) / 2 - 1; current >= 0; --current )

adjust_heap( first, current, last - first, *(first + current) );

while ( first < last )

pop_heap( first, last-- );

}

C++ (другой вариант)

#include <iostream>

#include <conio.h>

using namespace std;

void iswap(int &n1, int &n2)

{

int temp = n1;

n1 = n2;

n2 = temp;

}

int main()

{

int const n = 100;

int a[n];

for ( int i = 0; i < n; ++i ) { a[i] = n - i; cout << a[i] << " "; }

//заполняем массив для наглядности.

//-----------сортировка------------//

//сортирует по-возрастанию. чтобы настроить по-убыванию,

//поменяйте знаки сравнения в строчках, помеченных /*(знак)*/

int sh = 0; //смещение

bool b = false;

for(;;)

{

b = false;

for ( int i = 0; i < n; i++ )

{

if( i * 2 + 2 + sh < n )

{

if( ( a[i + sh] > /*<*/ a[i * 2 + 1 + sh] ) || ( a[i + sh] > /*<*/ a[i * 2 + 2 + sh] ) )

{

if ( a[i * 2 + 1 + sh] < /*>*/ a[i * 2 + 2 + sh] )

{

iswap( a[i + sh], a[i * 2 + 1 + sh] );

b = true;

}

else if ( a[i * 2 + 2 + sh] < /*>*/ a[ i * 2 + 1 + sh])

{

iswap( a[ i + sh], a[i * 2 + 2 + sh]);

b = true;

}

}

//дополнительная проверка для последних двух элементов

//с помощью этой проверки можно отсортировать пирамиду

//состоящую всего лишь из трех элементов

if( a[i*2 + 2 + sh] < /*>*/ a[i*2 + 1 + sh] )

{

iswap( a[i*2+1+sh], a[i * 2 +2+ sh] );

b = true;

}

}

else if( i * 2 + 1 + sh < n )

{

if( a[i + sh] > /*<*/ a[ i * 2 + 1 + sh] )

{

iswap( a[i + sh], a[i * 2 + 1 + sh] );

b = true;

}

}

}

if (!b) sh++; //смещение увеличивается, когда на текущем этапе

//сортировать больше нечего

if ( sh + 2 == n ) break;

} //конец сортировки

cout << endl << endl;

for ( int i = 0; i < n; ++i ) cout << a[i] << " ";

getch();

return 0;

}

C#

static Int32 add2pyramid(Int32[] arr, Int32 i, Int32 N)

{

Int32 imax;

Int32 buf;

if ((2 * i + 2) < N)

{

if (arr[2 * i + 1] < arr[2 * i + 2]) imax = 2 * i + 2;

else imax = 2 * i + 1;

}

else imax = 2 * i + 1;

if (imax >= N) return i;

if (arr[i] < arr[imax])

{

buf = arr[i];

arr[i] = arr[imax];

arr[imax] = buf;

if (imax < N / 2) i = imax;

}

return i;

}

static void Pyramid_Sort(Int32[] arr, Int32 len)

{

//step 1: building the pyramid

for (Int32 i = len / 2 - 1; i >= 0; --i)

{

long prev_i = i;

i = add2pyramid(arr, i, len);

if (prev_i != i) ++i;

}

//step 2: sorting

Int32 buf;

for (Int32 k = len - 1; k > 0; --k)

{

buf = arr[0];

arr[0] = arr[k];

arr[k] = buf;

Int32 i = 0, prev_i = -1;

while (i != prev_i)

{

prev_i = i;

i = add2pyramid(arr, i, k);

}

}

}

static void Main(string[] args)

{

Int32[] arr = new Int32[100];

//заполняем массив случайными числами

Random rd = new Random();

for(Int32 i = 0; i < arr.Length; ++i) {

arr[i] = rd.Next(1, 101);

}

System.Console.WriteLine("The array before sorting:");

foreach (Int32 x in arr)

{

System.Console.Write(x + " ");

}

//сортировка

Pyramid_Sort(arr, arr.Length);

System.Console.WriteLine("nnThe array after sorting:");

foreach (Int32 x in arr)

{

System.Console.Write(x + " ");

}

System.Console.WriteLine("nnPress the <Enter> key");

System.Console.ReadLine();

}

C# (другой вариант)

public class Heap<T>

{

private T[] _array; //массив сортируемых элементов

private int heapsize;//число необработанных элементов

private IComparer<T> _comparer;

public Heap(T[] a, IComparer<T> comparer){

_array = a;

heapsize = a.Length;

_comparer = comparer;

}

public void HeapSort(){

build_max_heap();//Построение пирамиды

for(int i = _array.Length - 1; i > 0; i--){

T temp = _array[0];//Переместим текущий максимальный элемент из нулевой позиции в хвост массива

_array[0] = _array[i];

_array[i] = temp;

heapsize--;//Уменьшим число необработанных элементов

max_heapify(0);//Восстановление свойства пирамиды

}

}

private int parent (int i) { return (i-1)/2; }//Индекс родительского узла

private int left (int i) { return 2*i+1; }//Индекс левого потомка

private int right (int i) { return 2*i+2; }//Индекс правого потомка

//Метод переупорядочивает элементы пирамиды при условии,

//что элемент с индексом i меньше хотя бы одного из своих потомков, нарушая тем самым свойство невозрастающей пирамиды

private void max_heapify(int i){

int l = left(i);

int r = right(i);

int lagest = i;

if (l<heapsize && _comparer.Compare(_array[l], _array[i])>0)

lagest = l;

if (r<heapsize && _comparer.Compare(_array[r], _array[lagest])>0)

lagest = r;

if (lagest != i)

{

T temp = _array[i];

_array[i] = _array[lagest];

_array[lagest] = temp;

max_heapify(lagest);

}

}

//метод строит невозрастающую пирамиду

private void build_max_heap(){

int i = (_array.Length-1)/2;

while(i>=0){

max_heapify(i);

i--;

}

}

}

public class IntComparer : IComparer<int>

{

public int Compare(int x, int y) {return x-y;}

}

public static void Main (string[] args)

{

int[] arr = Console.ReadLine().Split(' ').Select(s=>int.Parse(s)).ToArray();//вводим элементы массива через пробел

IntComparer myComparer = new IntComparer();//Класс, реализующий сравнение

Heap<int> heap = new Heap<int>(arr, myComparer);

heap.HeapSort();

}

Здесь T — любой тип, на множестве элементов которого можно ввести отношение частичного порядка.

Pascal

Вместо «SomeType» следует подставить любой из арифметических типов (например integer).

type SomeType=integer;

procedure Sort(var Arr: array of SomeType; Count: Integer);

procedure DownHeap(index, Count: integer; Current: SomeType);

//Функция пробегает по пирамиде восстанавливая ее

//Также используется для изначального создания пирамиды

//Использование: Передать номер следующего элемента в index

//Процедура пробежит по всем потомкам и найдет нужное место для следующего элемента

var

Child: Integer;

begin

while index < Count div 2 do begin

Child := (index+1)*2-1;

if (Child < Count-1) and (Arr[Child] < Arr[Child+1]) then

Child:=Child+1;

if Current >= Arr[Child] then

break;

Arr[index] := Arr[Child];

index := Child;

end;

Arr[index] := Current;

end;

//Основная функция

var

i: integer;

Current: SomeType;

begin

//Собираем пирамиду

for i := (Count div 2)-1 downto 0 do

DownHeap(i, Count, Arr[i]);

//Пирамида собрана. Теперь сортируем

for i := Count-1 downto 0 do begin

Current := Arr[i]; //перемещаем верхушку в начало отсортированного списка

Arr[i] := Arr[0];

DownHeap(0, i, Current); //находим нужное место в пирамиде для нового элемента

end;

end;

var tarr:array of SomeType;

i,n:SomeType;

begin

writeln('Введите размер массива: ');

readln(n);

setlength(tarr,n) ;//Выделяем память под динамический массив

randomize;

for i:=0 to n-1 do begin

tarr[i]:=random(500);//Генерируем случайность

write (tarr[i]:4);

end;

writeln();

writeln('Всё сортирует');

Sort(tarr,n);

for i:=0 to n-1 do begin

write (tarr[i]:4);

end;

end.

Pascal (другой вариант)

Примечание: myarray = array[1..Size] of integer; N — количество элементов массива

procedure HeapSort(var m: myarray; N: integer);

var

i: integer;

procedure Swap(var a,b:integer);

var

tmp: integer;

begin

tmp:=a;

a:=b;

b:=tmp;

end;

procedure Sort(Ns: integer);

var

i, tmp, pos, mid: integer;

begin

mid := Ns div 2;

for i := mid downto 1 do

begin

pos := i;

while pos<=mid do

begin

tmp := pos*2;

if tmp<Ns then

begin

if m[tmp+1]<m[tmp] then

tmp := tmp+1;

if m[pos]>m[tmp] then

begin

Swap(m[pos], m[tmp]);

pos := tmp;

end

else

pos := Ns;

end

else

if m[pos]>m[tmp] then

begin

Swap(m[pos], m[tmp]);

pos := Ns;

end

else

pos := Ns;

end;

end;

end;

begin

for i:=N downto 2 do

begin

Sort(i);

Swap(m[1], m[i]);

end;

end;

Pascal (третий вариант)

type TArray=array [1..10] of integer;

//процедура для перессылки записей

procedure swap(var x,y:integer);

var temp:integer;

begin

temp:=x;

x:=y;

y:=temp;

end;

//процедура приведения массива к пирамидальному виду (to pyramide)

procedure toPyr(var data:TArray; n:integer); //n - размерность массива

var i:integer;

begin

for i:=n div 2 downto 1 do begin

if 2*i<=n then if data[i]<data[2*i] then swap(data[i],data[2*i]);

if 2*i+1<=n then if data[i]<data[2*i+1] then swap(data[i],data[2*i+1]);

end;

end;

//процедура для сдвига массива влево

procedure left(var data:TArray; n:integer);

var i:integer;

temp:integer;

begin

temp:=data[1];

for i:=1 to n-1 do

data[i]:=data[i+1];

data[n]:=temp;

end;

//основная программа

var a:TArray;

i,n:integer;

begin

n:=10;//Не больше 10, потому что массив статический -

//type TArray=array [1..10] of integer;

randomize;

for i:=1 to n do begin

a[i]:=random(500);//Генерируем случайность

write (a[i]:4);

end;

for i:=n downto 1 do begin

topyr(a,i);

left(a,n);

end;

writeln();

writeln('Сортируем');

for i:=1 to n do begin

write (a[i]:4);

end;

end.

Python

def heapSort(li):

"""Сортирует список в возрастающем порядке с помощью алгоритма пирамидальной сортировки"""

def downHeap(li, k, n):

new_elem = li[k]

while 2*k+1 < n:

child = 2*k+1

if child+1 < n and li[child] < li[child+1]:

child += 1

if new_elem >= li[child]:

break

li[k] = li[child]

k = child

li[k] = new_elem

size = len(li)

for i in range(size//2-1,-1,-1):

downHeap(li, i, size)

for i in range(size-1,0,-1):

temp = li[i]

li[i] = li[0]

li[0] = temp

downHeap(li, 0, i)

Python (другой вариант)

def heapsort(s):

sl = len(s)

def swap(pi, ci):

if s[pi] < s[ci]:

s[pi], s[ci] = s[ci], s[pi]

def sift(pi, unsorted):

i_gt = lambda a, b: a if s[a] > s[b] else b

while pi*2+2 < unsorted:

gtci = i_gt(pi*2+1, pi*2+2)

swap(pi, gtci)

pi = gtci

# heapify

for i in range((sl/2)-1, -1, -1):

sift(i, sl)

# sort

for i in range(sl-1, 0, -1):

swap(i, 0)

sift(0, i)

Perl

@out=(6,4,2,8,5,3,1,6,8,4,3,2,7,9,1)

$N=@out+0;

if($N>1){

while($sh+2!=$N){

$b=undef;

for my$i(0..$N-1){

if($i*2+2+$sh<$N){

if($out[$i+$sh]gt$out[$i*2+1+$sh] || $out[$i+$sh]gt$out[$i*2+2+$sh]){

if($out[$i*2+1+$sh]lt$out[$i*2+2+$sh]){

($out[$i*2+1+$sh],$out[$i+$sh])=($out[$i+$sh],$out[$i*2+1+$sh]);

$b=1;

}elsif($out[$i*2+2+$sh]lt$out[$i*2+1+$sh]){

($out[$i*2+2+$sh],$out[$i+$sh])=($out[$i+$sh],$out[$i*2+2+$sh]);

$b=1;

}

}elsif($out[$i*2+2+$sh]lt$out[$i*2+1+$sh]){

($out[$i*2+1+$sh],$out[$i*2+2+$sh])=($out[$i*2+2+$sh],$out[$i*2+1+$sh]);

$b=1;

}

}elsif($i*2+1+$sh<$N && $out[$i+$sh]gt$out[$i*2+1+$sh]){

($out[$i+$sh],$out[$i*2+1+$sh])=($out[$i*2+1+$sh],$out[$i+$sh]);

$b=1;

}

}

++$sh if!$b;

last if$sh+2==$N;

}

}

Java

/**

* Класс для сортировки массива целых чисел с помощью кучи.

* Методы в классе написаны в порядке их использования. Для сортировки

* вызывается статический метод sort(int[] a)

*/

class HeapSort {

/**

* Размер кучи. Изначально равен размеру сортируемого массива

*/

private static int heapSize;

/**

* Сортировка с помощью кучи.

* Сначала формируется куча:

* @see HeapSort#buildHeap(int[])

* Теперь максимальный элемент массива находится в корне кучи. Его нужно

* поменять местами с последним элементом и убрать из кучи (уменьшить

* размер кучи на 1). Теперь в корне кучи находится элемент, который раньше

* был последним в массиве. Нужно переупорядочить кучу так, чтобы

* выполнялось основное условие кучи - a[parent]>=a[child]:

* @see #heapify(int[], int)

* После этого в корне окажется максимальный из оставшихся элементов.

* Повторить до тех пор, пока в куче не останется 1 элемент

*

* @param a сортируемый массив

*/

public static void sort(int[] a) {

buildHeap(a);

while (heapSize > 1) {

swap(a, 0, heapSize - 1);

heapSize--;

heapify(a, 0);

}

}

/**

* Построение кучи. Поскольку элементы с номерами начиная с a.length / 2 + 1

* это листья, то нужно переупорядочить поддеревья с корнями в индексах

* от 0 до a.length / 2 (метод heapify вызывать в порядке убывания индексов)

*

* @param a - массив, из которого формируется куча

*/

private static void buildHeap(int[] a) {

heapSize = a.length;

for (int i = a.length / 2; i >= 0; i--) {

heapify(a, i);

}

}

/**

* Переупорядочивает поддерево кучи начиная с узла i так, чтобы выполнялось

* основное свойство кучи - a[parent] >= a[child].

*

* @param a - массив, из которого сформирована куча

* @param i - корень поддерева, для которого происходит переупорядосивание

*/

private static void heapify(int[] a, int i) {

int l = left(i);

int r = right(i);

int largest = i;

if (l < heapSize && a[i] < a[l]) {

largest = l;

}

if (r < heapSize && a[largest] < a[r]) {

largest = r;

}

if (i != largest) {

swap(a, i, largest);

heapify(a, largest);

}

}

/**

* Возвращает индекс правого потомка текущего узла

*

* @param i индекс текущего узла кучи

* @return индекс правого потомка

*/

private static int right(int i) {

return 2 * i + 1;

}

/**

* Возвращает индекс левого потомка текущего узла

*

* @param i индекс текущего узла кучи

* @return индекс левого потомка

*/

private static int left(int i) {

return 2 * i + 2;

}

/**

* Меняет местами два элемента в массиве

*

* @param a массив

* @param i индекс первого элемента

* @param j индекс второго элемента

*/

private static void swap(int[] a, int i, int j) {

int temp = a[i];

a[i] = a[j];

a[j] = temp;

}

}

Достоинства

- Имеет доказанную оценку худшего случая

.

- Сортирует на месте, то есть требует всего O(1) дополнительной памяти (если дерево организовывать так, как показано выше).

Недостатки

- Сложен в реализации.

- Неустойчив — для обеспечения устойчивости нужно расширять ключ.

- На почти отсортированных массивах работает столь же долго, как и на хаотических данных.

- На одном шаге выборку приходится делать хаотично по всей длине массива — поэтому алгоритм плохо сочетается с кэшированием и подкачкой памяти.

- Методу требуется «мгновенный» прямой доступ; не работает на связанных списках и других структурах памяти последовательного доступа.

Сортировка слиянием при расходе памяти O(n) быстрее (

Из-за сложности алгоритма выигрыш получается только на больших n. На небольших n (до нескольких тысяч) быстрее сортировка Шелла.

При написании статьи были использованы открытые источники сети интернет :

Wikipedia

Kvodo

Youtube

Алгоритм пирамидальной сортировки по-английски называется «Heap Sort». «Heap» переводится, как «куча». В связи с этим пирамидальную сортировку ещё называют «сортировка кучей»

Оставим в стороне религиозные споры о преимуществах и недостатках алгоритма Quick Sort, и будем рассматривать пирамидальную сортировку, как самый быстрый алгоритм из доступных (см. Лекцию №3) для сортировки небольших объёмов данных (умещающихся в кеш процессора).

Пирамидальная сортировка была предложена Дж. Уильямсом в 1964 году. Это алгоритм сортировки массива произвольных элементов, не требующий дополнительной памяти и дополнительных структур данных. Время работы алгоритма —

Везде в этой лекции будем считать, что первый элемент массива имеет индекс 0.

Двоичное дерево

Двоичное дерево — структура данных, в которой каждый элемент имеет левого и/или правого потомка, либо вообще не имеет потомков. В последнем случае элемент называется листовым.

Если элемент A имеет потомка B, то элемент A называется родителем элемента B. В двоичном дереве существует единственный элемент, который не имеет родителей; такой элемент называется корневым.

Пример двоичного дерева показан на рисунке 1:

Рис. 1. Пример двоичного дерева

Почти заполненным двоичным деревом называется двоичное дерево, обладающее тремя свойствами:

- все листовые элементы находятся в нижнем уровне, либо в нижних двух уровнях;

- все листья в уровне заполняют уровень слева;

- все уровни (кроме, быть может, последнего уровня) полностью заполнены элементами.

Дерево на рис. 1 не является почти заполненным, так как уровень 4 не заполнен слева (элемент g «мешает»), и третий уровень (не являющийся последним), не заполнен полностью.

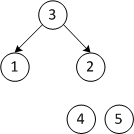

Почти заполненное двоичное дерево можно хранить в массиве без дополнительных затрат. Для этого достаточно перенумеровать элементы каждого уровня слева-направо:

Рис. 2. Пример нумерации элементов почти заполненного дерева

Нетрудно видеть, что при такой нумерации потомки узла с номером n (если есть) имеют номера

Рис. 3. Пример нахождения потомков и родителя в массиве

Пирамида

Возрастающей пирамидой называется почти заполненное дерево, в котором значение каждого элемента больше либо равно значения всех его потомков. Аналогично, в убывающей пирамиде значение каждого элемента меньше либо равно значения потомков.

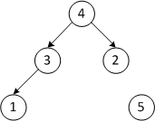

Пример возрастающей пирамиды показан на рисунке:

Рис. 4. Пример возрастающей пирамиды

Очевидно, самое большое значение в возрастающей пирамиде имеет корневой элемент. Однако, из свойств пирамиды не следует, что значения элементов уменьшаются с увеличением уровня. В частности, на рис. 4 элемент со значением 3 на четвёртом уровне больше значений всех элементов, кроме одного, на третьем уровне.

Важной операцией является отделение последнего (в смысле нумерации) элемента от пирамиды. Нетрудно доказать, что в этом случае двоичное дерево остаётся почти заполненным, и все свойства пирамиды сохраняются.

Просеивание вверх

Рассмотрим теперь задачу присоединения элемента с произвольным значением к возрастающей пирамиде. Если просто добавить элемент в конец массива, то свойство пирамиды (значение любого элемента

- если элемент корневой, или его значение

значения родителя, то конец;

- меняем местами значения элемента и его родителя;

- выполняем процедуру просеивания вверх для родителя.

После выполнения данной процедуры свойство пирамиды будет восстановлено, так как:

- Если вновь добавленный элемент больше родителя, то он больше и второго потомка родителя, так как до добавления нового элемента было выполнено свойство пирамиды, и родитель был не меньше своего потомка. Поэтому после обмена значений элемента и родителя свойство пирамиды будет восстановлено в поддереве, корнем которого является родитель с новым значением.

- Но свойство пирамиды может быть нарушено в отношении родителя и родителя родителя (так как значение родителя стало больше). Процедура вызывается для родительского узла, чтобы восстановить это свойство.

Исходный код процедуры просеивания вверх я не привожу, так как он нам не понадобится. Пример просеивания вверх показан на рисунке:

Рис. 5. Процесс просеивания вверх добавленного элемента

Просеивание вниз

Что делать, если нам нужно заменить корневой элемент на какой-либо другой? В этом случае пирамидальную структуру двоичного дерева можно восстановить с помощью процедуры просеивания вниз:

- если элемент листовой, или его значение

значений потомков, то конец;

- меняем местами значения элемента и его потомка, имеющего максимальное значение;

- выполняем процедуру просеивания вниз для изменившегося потомка.

Исходный код процедуры просеивания вниз приведён в листинге 1:

template<class T> void SiftDown(T* const heap,int i,int const n)

{ //Просеивает элемент номер i вниз в пирамиде heap.

//n — размер пирамиды

//Идея в том, что вычисляется максимальный элемент из трёх:

// 1) текущий элемент

// 2) левый потомок

// 3) правый потомок

//Если индекс текущего элемента не равен индексу максималь-

// ного, то меняю их местами, и перехожу к максимальному

//Индекс максимального элемента с «предыдущей» итерации:

int nMax( i );

//Значение текущего элемента (не меняется):

T const value( heap[i] );

while(true)

{

//Номер текущего элемента — это номер максимального

// элемента с предыдущей итерации:

i = nMax;

int childN( i*2+1 ); //Индекс левого потомка

//Если есть левый потомок и он больше текущего элемента,

if ( ( childN < n ) && ( heap[childN] > value ) )

nMax = childN; // то он становится максимальным

++childN; //Индекс правого потомка

//Если есть правый потомок и он больше максимального,

if ( ( childN < n ) && ( heap[childN] > heap[nMax] ) )

nMax = childN; // то он становится максимальным

//Текущий элемент является максимальным —

// конец просеивания:

if (nMax == i) break;

//Меняю местами текущий элемент с максимальным:

heap[i] = heap[nMax]; heap[nMax] = value;

// при этом значение value будет в ячейке nMax,

// поэтому в начале следующей итерации значение value

// правильно, т.к. мы переходим именно к этой ячейке

};

}

Листинг 1. Функция просеивания вниз в возрастающей пирамиде

Пример просеивания вниз показан на рисунке:

Рис. 6. Процесс просеивания вниз изменённого корневого элемента

Построение пирамиды

Допустим, у нас есть произвольный набор из n элементов, и мы хотим построить из него пирамиду. Самый простой способ этого добиться — начать с пустой пирамиды, и добавлять в неё элементы один за другим, каждый раз вызывая процедуру просеивания вверх для нового элемента. Назовём этот метод построения пирамиды «методом просеивания вверх». Пример работы алгоритма показан на рисунке:

Рис. 7. Анимация простого алгоритма построения пирамиды

Рассчитаем быстродействие этого метода в самом плохом случае. Пусть массив уже отсортирован по возрастанию, и каждый добавляемый элемент вынужден просеиваться вверх до самого корня. Тогда при добавлении элемента номер i нам потребуется

|

(1) |

Оценим сумму в выражении (1) с помощью определённого интеграла:

|

(2) |

Вычисляя интегралы, получаем:

|

(3) |

Это означает, что:

|

(4) |

На самом деле пирамиду можно построить быстрее. Для этого заполним дерево элементами в случайном порядке (например так, как они идут в массиве изначально), и будем его исправлять.

Заметим, что если у нас есть две пирамиды, то, если их соединить общим корнем, а затем просеять корень вниз, то мы получим новую большую пирамиду. Деревья, состоящие из одного элемента, заведомо являются пирамидами, поэтому начнём с набора листовых элементов, а затем будем соединять имеющиеся пирамиды попарно до тех пор, пока не получим одну большую пирамиду. Первый добавляемый корень имеет индекс

Вычислим быстродействие этого алгоритма в худшем случае. Пусть массив отсортирован по возрастанию, и каждый добавляемый корень должен быть просеян в самый низ. Высота дерева примерно равна

|

(5) |

Оценивая сумму интегралами аналогично (2), (3), получим:

|

(6) |

В дальнейшем будем строить пирамиду методом просеивания вниз.

Сортировка

Имея построенную пирамиду, несложно реализовать сортировку. Так как корневой узел пирамиды имеет самое большое значение, мы можем отделить его и поместить в конец массива. Вместо корневого узла можно поставить последний узел дерева и, просеяв его вниз, снова получить пирамиду. В новом дереве корень имеет самое большое значение среди оставшихся элементов. Его снова можно отделить, и так далее. Алгоритм получается следующий:

- поменять местами значения первого и последнего узлов пирамиды;

- отделить последний узел от дерева, уменьшив размер дерева на единицу (элемент остаётся в массиве);

- восстановить пирамиду, просеяв вниз её новый корневой элемент;

- перейти к пункту 1;

По мере работы алгоритма, часть массива, занятая деревом, уменьшается, а в конце массива накапливается отсортированный результат.

Реализация пирамидальной сортировки на языке программирования C++ приведена в листинге 2 (используется процедура просеивания вниз из листинга 1):

template<class T> void HeapSort(T* const heap, int n)

{ //Пирамидальная сортировка массива heap.

// n — размер массива

//Этап 1: построение пирамиды из массива

for(int i(n/2—1); i>=0; —i) SiftDown(heap, i, n);

//Этап 2: сортировка с помощью пирамиды.

// Здесь под «n» понимается размер пирамиды

while( n > 1 ) //Пока в пирамиде больше одного элемента

{

—n; //Отделяю последний элемент

//Меняю местами корневой элемент и отделённый:

T const firstElem( heap[0] );

heap[0] = heap[n];

heap[n] = firstElem;

//Просеиваю новый корневой элемент:

SiftDown(heap, 0, n);

}

}

Листинг 2. Пирамидальная сортировка

Теоретическое время работы этого алгоритма нетрудно оценить, если заметить, что пирамидальная сортировка (без учёта начального построения пирамиды) полностью аналогична построению пирамиды методом просеивания вверх, только производится «в обратном порядке»: пирамида не строится, а «разбирается» элемент-за-элементом, и элементы просеиваются не вверх, а вниз. Поэтому время работы алгоритма пирамидальной сортировки

|

(7) |

Тогда общее время сортировки (с учётом построения пирамиды) будет равно:

|

(8) |

Измерение быстродействия алгоритма

Мы уже выяснили с помощью теоретических оценок, что время работы алгоритма пирамидальной сортировки равно:

На рис. 8 показан график величины

|

(9) |

где n — количество сортируемых псевдослучайных четырёхбайтовых целых чисел,

Мой процессор: Intel Mobile Core 2 Duo T7500 (во время тестов программа работала на одном ядре). Тактовая частота: 2.2 ГГц. Кэш L2: 4 МБ, 16-ассоциативный, 64 байта на строку.

Для каждого числа элементов было выполнено восемь тестов, и из их результатов был взят минимум, чтобы исключить случайное влияние других вычислительных задач на ход эксперимента.

Рис. 8. Отношение времени пирамидальной сортировки к

На графике проявляются две важные особенности алгоритма:

- Алгоритм относительно медленно работает, когда число сортируемых элементов меньше сотни. Для малого числа элементов желательно использовать сортировочные сети; об этом я расскажу в одной из следующих лекций.

- Когда количество сортируемых данных начинает превышать размер кэша (в нашем случае миллион чисел по 4 байта), скорость сортировки падает. Это вызвано тем, что алгоритм обращается к элементам массива довольно случайным образом (с точки зрения алгоритма работы кеша). По мере того, как всё меньшая часть данных уменьшается в кеше, скорость работы алгоритма всё более определяется скоростью работы оперативной памяти, а не скоростью работы кеша. В одной из следующих лекций мы устраним этот недостаток.

Heap Sort is a popular and efficient sorting algorithm in computer programming. Learning how to write the heap sort algorithm requires knowledge of two types of data structures — arrays and trees.

The initial set of numbers that we want to sort is stored in an array e.g. [10, 3, 76, 34, 23, 32] and after sorting, we get a sorted array [3,10,23,32,34,76].

Heap sort works by visualizing the elements of the array as a special kind of complete binary tree called a heap.

Note: As a prerequisite, you must know about a complete binary tree and heap data structure.

Relationship between Array Indexes and Tree Elements

A complete binary tree has an interesting property that we can use to find the children and parents of any node.

If the index of any element in the array is i, the element in the index 2i+1 will become the left child and element in 2i+2 index will become the right child. Also, the parent of any element at index i is given by the lower bound of (i-1)/2.

Let’s test it out,

Left child of 1 (index 0) = element in (2*0+1) index = element in 1 index = 12 Right child of 1 = element in (2*0+2) index = element in 2 index = 9 Similarly, Left child of 12 (index 1) = element in (2*1+1) index = element in 3 index = 5 Right child of 12 = element in (2*1+2) index = element in 4 index = 6

Let us also confirm that the rules hold for finding parent of any node

Parent of 9 (position 2) = (2-1)/2 = ½ = 0.5 ~ 0 index = 1 Parent of 12 (position 1) = (1-1)/2 = 0 index = 1

Understanding this mapping of array indexes to tree positions is critical to understanding how the Heap Data Structure works and how it is used to implement Heap Sort.

What is Heap Data Structure?

Heap is a special tree-based data structure. A binary tree is said to follow a heap data structure if

- it is a complete binary tree

- All nodes in the tree follow the property that they are greater than their children i.e. the largest element is at the root and both its children and smaller than the root and so on. Such a heap is called a max-heap. If instead, all nodes are smaller than their children, it is called a min-heap

The following example diagram shows Max-Heap and Min-Heap.

To learn more about it, please visit Heap Data Structure.

How to «heapify» a tree

Starting from a complete binary tree, we can modify it to become a Max-Heap by running a function called heapify on all the non-leaf elements of the heap.

Since heapify uses recursion, it can be difficult to grasp. So let’s first think about how you would heapify a tree with just three elements.

heapify(array)

Root = array[0]

Largest = largest( array[0] , array [2*0 + 1]. array[2*0+2])

if(Root != Largest)

Swap(Root, Largest)The example above shows two scenarios — one in which the root is the largest element and we don’t need to do anything. And another in which the root had a larger element as a child and we needed to swap to maintain max-heap property.

If you’re worked with recursive algorithms before, you’ve probably identified that this must be the base case.

Now let’s think of another scenario in which there is more than one level.

The top element isn’t a max-heap but all the sub-trees are max-heaps.

To maintain the max-heap property for the entire tree, we will have to keep pushing 2 downwards until it reaches its correct position.

Thus, to maintain the max-heap property in a tree where both sub-trees are max-heaps, we need to run heapify on the root element repeatedly until it is larger than its children or it becomes a leaf node.

We can combine both these conditions in one heapify function as

void heapify(int arr[], int n, int i) {

// Find largest among root, left child and right child

int largest = i;

int left = 2 * i + 1;

int right = 2 * i + 2;

if (left < n && arr[left] > arr[largest])

largest = left;

if (right < n && arr[right] > arr[largest])

largest = right;

// Swap and continue heapifying if root is not largest

if (largest != i) {

swap(&arr[i], &arr[largest]);

heapify(arr, n, largest);

}

}This function works for both the base case and for a tree of any size. We can thus move the root element to the correct position to maintain the max-heap status for any tree size as long as the sub-trees are max-heaps.

Build max-heap

To build a max-heap from any tree, we can thus start heapifying each sub-tree from the bottom up and end up with a max-heap after the function is applied to all the elements including the root element.

In the case of a complete tree, the first index of a non-leaf node is given by n/2 - 1. All other nodes after that are leaf-nodes and thus don’t need to be heapified.

So, we can build a maximum heap as

// Build heap (rearrange array)

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);As shown in the above diagram, we start by heapifying the lowest smallest trees and gradually move up until we reach the root element.

If you’ve understood everything till here, congratulations, you are on your way to mastering the Heap sort.

Working of Heap Sort

- Since the tree satisfies Max-Heap property, then the largest item is stored at the root node.

- Swap: Remove the root element and put at the end of the array (nth position) Put the last item of the tree (heap) at the vacant place.

- Remove: Reduce the size of the heap by 1.

- Heapify: Heapify the root element again so that we have the highest element at root.

- The process is repeated until all the items of the list are sorted.

The code below shows the operation.

// Heap sort

for (int i = n - 1; i >= 0; i--) {

swap(&arr[0], &arr[i]);

// Heapify root element to get highest element at root again

heapify(arr, i, 0);

}# Heap Sort in python

def heapify(arr, n, i):

# Find largest among root and children

largest = i

l = 2 * i + 1

r = 2 * i + 2

if l < n and arr[i] < arr[l]:

largest = l

if r < n and arr[largest] < arr[r]:

largest = r

# If root is not largest, swap with largest and continue heapifying

if largest != i:

arr[i], arr[largest] = arr[largest], arr[i]

heapify(arr, n, largest)

def heapSort(arr):

n = len(arr)

# Build max heap

for i in range(n//2, -1, -1):

heapify(arr, n, i)

for i in range(n-1, 0, -1):

# Swap

arr[i], arr[0] = arr[0], arr[i]

# Heapify root element

heapify(arr, i, 0)

arr = [1, 12, 9, 5, 6, 10]

heapSort(arr)

n = len(arr)

print("Sorted array is")

for i in range(n):

print("%d " % arr[i], end='')

// Heap Sort in Java

public class HeapSort {

public void sort(int arr[]) {

int n = arr.length;

// Build max heap

for (int i = n / 2 - 1; i >= 0; i--) {

heapify(arr, n, i);

}

// Heap sort

for (int i = n - 1; i >= 0; i--) {

int temp = arr[0];

arr[0] = arr[i];

arr[i] = temp;

// Heapify root element

heapify(arr, i, 0);

}

}

void heapify(int arr[], int n, int i) {

// Find largest among root, left child and right child

int largest = i;

int l = 2 * i + 1;

int r = 2 * i + 2;

if (l < n && arr[l] > arr[largest])

largest = l;

if (r < n && arr[r] > arr[largest])

largest = r;

// Swap and continue heapifying if root is not largest

if (largest != i) {

int swap = arr[i];

arr[i] = arr[largest];

arr[largest] = swap;

heapify(arr, n, largest);

}

}

// Function to print an array

static void printArray(int arr[]) {

int n = arr.length;

for (int i = 0; i < n; ++i)

System.out.print(arr[i] + " ");

System.out.println();

}

// Driver code

public static void main(String args[]) {

int arr[] = { 1, 12, 9, 5, 6, 10 };

HeapSort hs = new HeapSort();

hs.sort(arr);

System.out.println("Sorted array is");

printArray(arr);

}

}// Heap Sort in C

#include <stdio.h>

// Function to swap the the position of two elements

void swap(int *a, int *b) {

int temp = *a;

*a = *b;

*b = temp;

}

void heapify(int arr[], int n, int i) {

// Find largest among root, left child and right child

int largest = i;

int left = 2 * i + 1;

int right = 2 * i + 2;

if (left < n && arr[left] > arr[largest])

largest = left;

if (right < n && arr[right] > arr[largest])

largest = right;

// Swap and continue heapifying if root is not largest

if (largest != i) {

swap(&arr[i], &arr[largest]);

heapify(arr, n, largest);

}

}

// Main function to do heap sort

void heapSort(int arr[], int n) {

// Build max heap

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);

// Heap sort

for (int i = n - 1; i >= 0; i--) {

swap(&arr[0], &arr[i]);

// Heapify root element to get highest element at root again

heapify(arr, i, 0);

}

}

// Print an array

void printArray(int arr[], int n) {

for (int i = 0; i < n; ++i)

printf("%d ", arr[i]);

printf("n");

}

// Driver code

int main() {

int arr[] = {1, 12, 9, 5, 6, 10};

int n = sizeof(arr) / sizeof(arr[0]);

heapSort(arr, n);

printf("Sorted array is n");

printArray(arr, n);

}// Heap Sort in C++

#include <iostream>

using namespace std;

void heapify(int arr[], int n, int i) {

// Find largest among root, left child and right child

int largest = i;

int left = 2 * i + 1;

int right = 2 * i + 2;

if (left < n && arr[left] > arr[largest])

largest = left;

if (right < n && arr[right] > arr[largest])

largest = right;

// Swap and continue heapifying if root is not largest

if (largest != i) {

swap(arr[i], arr[largest]);

heapify(arr, n, largest);

}

}

// main function to do heap sort

void heapSort(int arr[], int n) {

// Build max heap

for (int i = n / 2 - 1; i >= 0; i--)

heapify(arr, n, i);

// Heap sort

for (int i = n - 1; i >= 0; i--) {

swap(arr[0], arr[i]);

// Heapify root element to get highest element at root again

heapify(arr, i, 0);

}

}

// Print an array

void printArray(int arr[], int n) {

for (int i = 0; i < n; ++i)

cout << arr[i] << " ";

cout << "n";

}

// Driver code

int main() {

int arr[] = {1, 12, 9, 5, 6, 10};

int n = sizeof(arr) / sizeof(arr[0]);

heapSort(arr, n);

cout << "Sorted array is n";

printArray(arr, n);

}Heap Sort Complexity

| Time Complexity | |

|---|---|

| Best | O(nlog n) |

| Worst | O(nlog n) |

| Average | O(nlog n) |

| Space Complexity | O(1) |

| Stability | No |

Heap Sort has O(nlog n) time complexities for all the cases ( best case, average case, and worst case).

Let us understand the reason why. The height of a complete binary tree containing n elements is log n

As we have seen earlier, to fully heapify an element whose subtrees are already max-heaps, we need to keep comparing the element with its left and right children and pushing it downwards until it reaches a point where both its children are smaller than it.

In the worst case scenario, we will need to move an element from the root to the leaf node making a multiple of log(n) comparisons and swaps.

During the build_max_heap stage, we do that for n/2 elements so the worst case complexity of the build_heap step is n/2*log n ~ nlog n.

During the sorting step, we exchange the root element with the last element and heapify the root element. For each element, this again takes log n worst time because we might have to bring the element all the way from the root to the leaf. Since we repeat this n times, the heap_sort step is also nlog n.

Also since the build_max_heap and heap_sort steps are executed one after another, the algorithmic complexity is not multiplied and it remains in the order of nlog n.

Also it performs sorting in O(1) space complexity. Compared with Quick Sort, it has a better worst case ( O(nlog n) ). Quick Sort has complexity O(n^2) for worst case. But in other cases, Quick Sort is fast. Introsort is an alternative to heapsort that combines quicksort and heapsort to retain advantages of both: worst case speed of heapsort and average speed of quicksort.

Heap Sort Applications

Systems concerned with security and embedded systems such as Linux Kernel use Heap Sort because of the O(n log n) upper bound on Heapsort’s running time and constant O(1) upper bound on its auxiliary storage.