Завтра искусственный интеллект поработит Землю и станет использовать человеков в качестве смешных батареек, поддерживающих функционирование его систем, а сегодня мы запасаемся попкорном и смотрим, с чего он начинает.

19 октября 2017 года команда Deepmind опубликовала в Nature статью, краткая суть которой сводится к тому, что их новая модель AlphaGo Zero не только разгромно обыгрывает прошлые версии сети, но ещё и не требует никакого человеческого участия в процессе тренировки. Естественно, это заявление произвело в AI-коммьюнити эффект разорвавшейся бомбы, и всем тут же стало интересно, за счёт чего удалось добиться такого успеха.

По мотивам материалов, находящихся в открытом доступе, Семён sim0nsays записал отличный стрим:

А для тех, кому проще два раза прочитать, чем один раз увидеть, я сейчас попробую объяснить всё это буквами.

Сразу хочу отметить, что стрим и статья собирались в значительной степени по мотивам дискуссий на closedcircles.com, отсюда и спектр рассмотренных вопросов, и специфическая манера повествования.

Ну, поехали.

Что такое го?

Го — это древняя (по разным оценкам, ей от 2 до 5 тысяч лет) настольная стратегическая игра. Есть поле, расчерченное перпендикулярными линиями. Есть два игрока, у одного в мешочке белые камни, у другого — чёрные. Игроки по очереди выставляют камни на пересечение линий. Камни одного цвета, окружённые по четырём направлениям камнями другого цвета, снимаются с доски:

Выигрывает тот, кто к концу партии «окружит» большую по площади территорию. Там есть ещё несколько тонкостей, но базово это всё — человеку, который видит го первый раз в жизни, вполне реально объяснить правила за пять минут.

И почему это считается сложным?

Окей, давай попробуем сравнить несколько настольных игр.

Начнём с шашек. В шашках у игрока есть примерно 10 вариантов того, какой сделать ход. В 1994 году чемпион мира по шашкам был обыгран программой, написанной исследователями из университета Альберты.

Дальше шахматы. В шахматах игрок выбирает в среднем из 20 допустимых ходов и делает такой выбор приблизительно 50 раз за игру. В 1997 году Deep Blue, созданная командой IBM программа, обыграла чемпиона мира по шахматам Гарри Каспарова.

Теперь го. Профессионалы играют в го на поле размера 19х19, что даёт 361 вариант того, куда можно поставить камень. Отсекая откровенно проигрышные ходы и точки, занятые другими камнями, мы всё равно получаем выбор из более чем 200 опций, который требуется совершить в среднем 50-70 раз за партию. Ситуация осложняется тем, что камни взаимодействуют между собой, образуя построения, и в результате камень, поставленный на 35 ходу, может принести пользу только на 115. А может не принести. А чаще всего вообще трудно понять, помог нам этот ход или помешал. Тем не менее, в 2016 году программа AlphaGo обыграла сильнейшего (по меньшей мере, одного из сильнейших) игрока в мире Ли Седоля в серии из пяти игр со счётом 4:1.

Почему на победу в го потребовалось столько времени? Там так много вариантов?

Грубо говоря, да. И в шашках, и в шахматах, и в го общий принцип, по которому работают алгоритмы, один и тот же. Все эти игры попадают в категорию игр с полной информацией, значит, мы можем построить дерево всех возможных состояний игры. Поэтому мы банально строим такое дерево, а дальше просто идём по ветке, которая приводит к победе. Тонкость в том, что для го дерево получается ну очень большим из-за лютого фактора ветвления и впечатляющей глубины, и ни построить, ни обойти его за адекватное время не представлялось возможным. Именно эту проблему смогли решить ребята из DeepMind.

И как они победили?

Тут начинается интересное.

Сначала давай поговорим о том, как работали алгоритмы игры в го до AlphaGo. Все они показывали не самые впечатляющие результаты и успешно играли примерно на уровне среднего любителя, и все опирались на метод под названием Monte Carlo Tree Search — MCTS. Идея в чём (с этим важно разобраться).

У тебя есть дерево состояний — ходов. Из данной конкретной ситуации ты идёшь по какой-то из веток этого дерева, пока она не закончится. Когда ветка заканчивается, добавляешь в неё новый узел (ноду), тем самым инкрементально это дерево достраивая. А потом добавленную ноду оцениваешь, чтобы в дальнейшем определять, стоит ходить по данной ветке или не стоит, не раскрывая само дерево.

Чуть детальнее, это работает следующим образом:

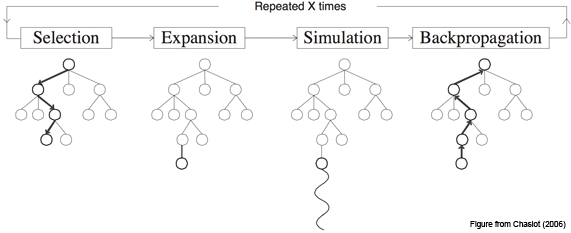

Шаг первый, Selection: у нас есть дерево позиций, и мы каждый раз совершаем ход, выбирая наилучший дочерний узел для текущей позиции.

Шаг второй, Expansion: допустим, мы дошли до конца дерева, но это ещё не конец игры. Просто создаём новую дочернюю ноду и идём в неё.

Шаг третий, Simulation: хорошо, появилась новая нода, фактически, игровая ситуация, в которой мы оказались впервые. Теперь надо её оценить, то есть понять, в хорошей мы оказались ситуации или не очень. Как это сделать? В базовой концепции — используя так называемый rollout: просто сыграть партию (или много партий) из текущей позиции и посмотреть, выиграли мы или проиграли. Получившийся результат и считаем оценкой узла.

Шаг четвёртый, Backpropagation: идём вверх по дереву и увеличиваем или уменьшаем веса всех родительских нод в зависимости от того, хороша новая нода или плоха. Пока важно понять общий принцип, мы ещё успеем рассмотреть данный этап в деталях.

В каждой ноде сохраняем два значения: оценку (value) текущей ноды и количество раз, которое мы по ней пробегали. И повторяем цикл из этих четырёх шагов много-много раз.

Как мы выбираем дочернюю ноду на первом шаге?

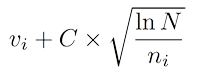

В самом простом варианте — берём ноду, у которой будет наивысший показатель Upper Confidence Bounds (UCB):

Здесь v — это value нашей ноды, n — сколько раз мы в этой ноде были, N — сколько раз были в родительской ноде, а C — просто некоторый коэффициент.

В не самом простом варианте можно усложнять формулу, чтобы получить более точные результаты, или вообще использовать какую-то другую эвристику, например, нейросеть. Об этом подходе мы тоже ещё поговорим.

Если смотреть чуть шире, перед нами классическая multi-armed bandit problem. Задача — найти такую функцию выбора узла, которая обеспечит оптимальный баланс между использованием лучших из имеющихся вариантов и исследованием новых возможностей.

Почему это работает?

Потому что с MCTS дерево решений растёт асимметрично: более интересные ноды посещаются чаще, менее интересные — реже, а оценить отдельно взятую ноду становится возможным без раскрытия всего дерева.

Это имеет какое-то отношение к AlphaGo?

В общем и целом, AlphaGo опирается на те же самые принципы. Ключевое отличие — когда на втором этапе мы добавляем новую ноду, для того, чтобы определить, насколько она хорошая, вместо rollout’ов используем нейросеть. Как мы это делаем.

(Я совсем в двух словах расскажу про прошлую версию AlphaGo, хотя на самом деле в ней хватает интересных нюансов; кто хочет подробностей — вэлком в видео в начале, там они хорошо объясняются, или в соответствующий пост на хабре, там они хорошо расписаны).

Во-первых, тренируем две сети, каждая из которых получает на вход состояние доски и говорит, какой бы ход в этой ситуации сделал человек. Почему две? Потому что одна — медленная, но работает хорошо (57% верных предсказаний, и каждый дополнительный процент даёт очень солидный бонус к итоговому результату), а вторая обладает намного меньшей точностью, зато быстрая.

Обе эти сети, медленную и быструю, мы тренируем на человеческих ходах — банально идём на сервер го, забираем партии игроков хорошего уровня, парсим и скармливаем для обучения.

Во-вторых, берём две эти натренированные «на людях» сети и начинаем играть ими сами с собой, чтобы их прокачать.

Примерно так.

В-третьих, тренируем value-сеть, которая получает на вход текущее состояние доски, а в ответ отдаёт число от -1 до 1 — вероятность выиграть, оказавшись в этой позиции в какой-то момент партии.

Таким образом, у нас есть одна медленная и точная функция, которая говорит, куда надо ходить (из шага 2), одна быстрая функция, которая делает то же самое, хоть и не так хорошо (опять же из шага 2), и третья функция, которая, глядя на доску, говорит, проиграешь ты или выиграешь, если окажешься в этой ситуации (из шага 3). Всё, теперь мы играем по MCTS и используем первую, чтобы посмотреть, в какие ноды следует соваться из текущей, вторую — чтобы очень быстро просимулировать rollout из текущей позиции, а третью — чтобы напрямую без rollout’а оценить, насколько хороша нода, в которую мы сунулись. Для итоговой value значения, выданные второй и третьей сетями, просто складываются. В результате мы и очень сильно урезаем фактор ветвления, и можем для оценки узла не лезть вниз по дереву (а если лезем, то быстро-быстро).

И это работает прям сильно лучше, чем вариант без нейросетей?

Да, внезапно этого оказывается достаточно.

В октябре 2015 AlphaGo играет с трёхкратным чемпионом Европы Fan Hui и обыгрывает его со счётом 5:0. Событие, с одной стороны, большое, потому что впервые компьютер выигрывает у профессионала в равных условиях, а с другой — не очень, потому что в мире го чемпион Европы — это примерно чемпион водокачки, и тот же Fan Hui обладает всего лишь вторым профессиональным даном (из девяти возможных). Версия AlphaGo, которая играла в этом матче, получила внутреннее название AlphaGo Fan.

А вот в марте 2016 новая версия AlphaGo играет пять партий уже с одним из лучших игроков мира Lee Sedol и выигрывает со счётом 4:1. Забавно, но сразу после игр в медиа к Ли Седолю стали относиться как к первому топ-игроку, проигравшему ИИ, хотя время расставило всё по местам и на сегодня Седоль остаётся (и, вероятно, останется навсегда) последним человеком, обыгравшим компьютер. Но я забегаю вперёд. Эта версия AlphaGo в дальнейшем стала обозначаться AlphaGo Lee.

Хорошая попытка, Ли, но нет.

После этого, в конце 2016 и начале 2017, уже следующая версия AlphaGo (AlphaGo Master) играет 60 матчей в онлайне с игроками из топовых позиций мирового рейтинга и выигрывает с общим счётом 60:0. В мае AlphaGo Master играет с топ-1 мирового рейтинга Ke Jie и обыгрывает его со счётом 3:0. Собственно, всё, противостояние человека и компьютера в го завершено.

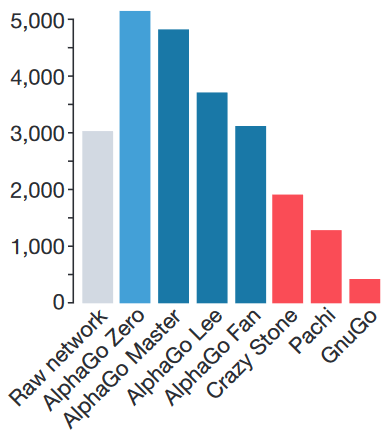

Рейтинг ELO. GnuGo, Pachi и CrazyStone — боты, написанные без использования нейросетей.

Но раз они и так всех обыграли, зачем понадобилась ещё одна сеть?

Если коротко — для красоты. У сообщества были три относительно большие претензии к AlphaGo:

1) Для стартового обучения используются игры людей. Получается, что без человеческого интеллекта искусственный интеллект не работает.

2) Много заинженеренных фич. Я опустил этот момент в своём пересказе, но в видео и в посте про AlphaGo Lee ему уделяется достаточно внимания, — обе используемые сети получают на вход значительное количество фич, придуманных людьми. Сами по себе эти фичи никакой новой информации не несут и могут быть вычислены, исходя из положения камней на доске, но вот без них сети не справляются. Например, сеть, которая определяет следующий ход, помимо непосредственно стейта получает следующее:

- сколько ходов назад был поставлен тот или иной камень;

- сколько свободных точек вокруг данного камня;

- сколько своих камней ты пожертвуешь, если сходишь в данную точку;

- легален ли вообще данный ход, то есть позволяется ли он правилами го;

- поучаствует ли камень, поставленный в эту точку, в так называемом “лестничном” построении;

и так далее — в общей сложности 48 слоёв с информацией. А “быстрой” сети, которая предсказывает вероятность победы, и вовсе отдают на вход сто с лишним тысяч заготовленных параметров. Получается, модель учится не играть в го per se, а показывать результаты в некотором заранее очень хорошо подготовленном окружении с большим количеством свойств, о которых ей рассказывает опять же человек.

3) Нужен здоровый кластер, чтобы всё это запустить.

И вот буквально месяц назад Deepmind представили новую версию алгоритма, AlphaGo Zero, в котором все эти проблемы устранены — модель учится с нуля, играя исключительно сама с собой и используя случайные веса нейросети в качестве стартовых; использует только положение камней на доске, чтобы принять решение; и сильно проще по требованиям к железу. Приятным бонусом она обыгрывает AlphaGo Lee в противостоянии из ста партий с общим счётом 100:0.

Так, и что для этого пришлось сделать?

Две большие штуки.

Во-первых, объединить две сети из прошлых версий AlphaGo в одну. Она получает состояние доски с небольшим количеством фич (я расскажу о них чуть позже), прогоняет всё это добро через свои слои, и в конце два её выхода выдают два результата: policy-выход выдаёт массив 19х19, который показывает, насколько вероятен каждый из ходов из данной позиции, а value выдаёт одно число — вероятность выиграть партию, опять же из данной позиции.

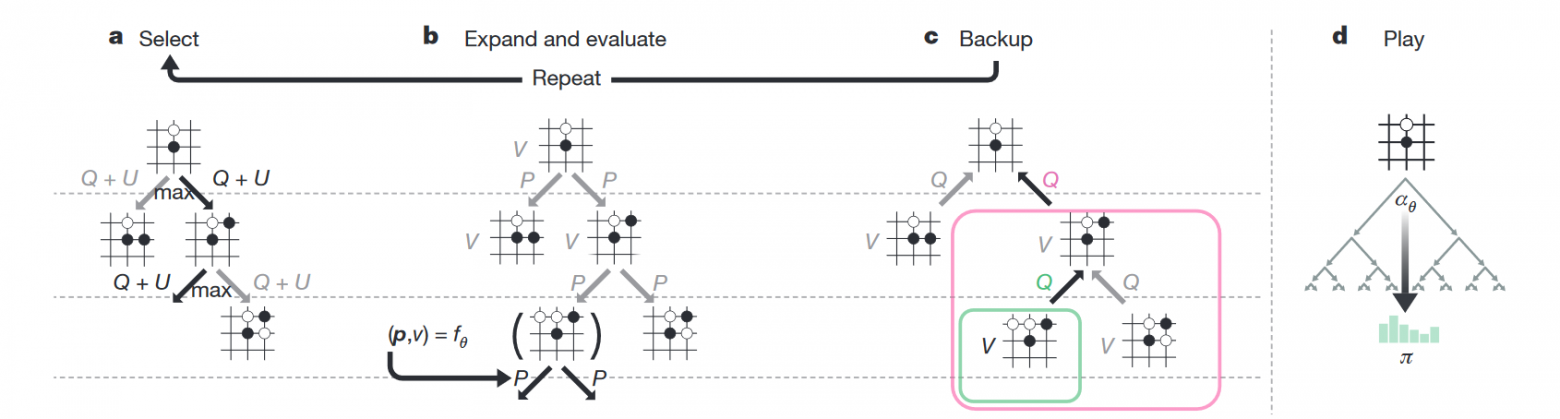

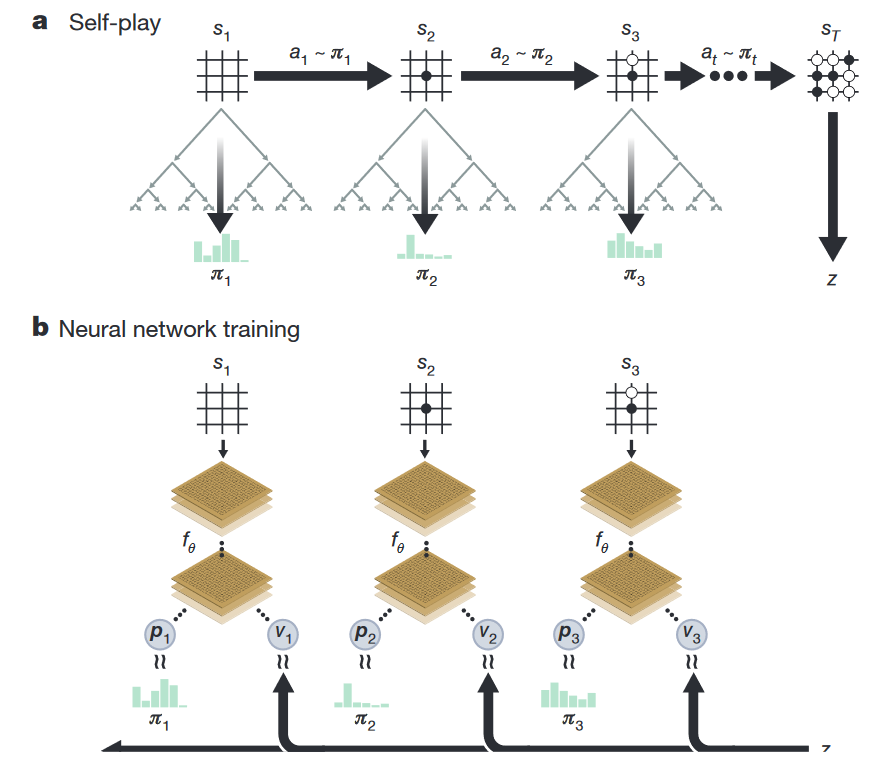

Во-вторых, поменять сам RL-алгоритм. Если раньше непосредственно MCTS использовался только во время игры, то теперь он используется сразу при тренировке. Как это работает.

В каждой ноде дерева состояний хранится четыре значения — N (сколько раз мы ходили по этой ноде), V (value этой ноды), Q (усреднённое value всех дочерних нод этой ноды) и P (вероятность, что из всех допустимых на данном ходу нод мы выберем именно эту). Когда сеть играет сама с собой, во время каждого хода она производит следующие симуляции:

- Берёт дерево, корнем которого является текущая нода.

- Идёт в ту дочернюю ноду, где больше Q + U (U — добавка, стимулирующая поиск новых путей; она больше в начале тренировки и меньше — в дальнейшем).

- Таким нехитрым образом доходит до конца дерева — состояния, когда дочерних узлов нет, а игра ещё не закончена.

- Отдаёт это состояние на вход нейросети, в ответ получает v (value текущей ноды) и p (вероятности следующих ходов).

- Записывает v в ноду.

- Создаёт дочерние ноды с P согласно p и нулевыми N, V и Q.

- Обновляет все ноды выше текущей, которые были выбраны во время симуляции, следующим образом: N := N + 1; V := V + v; Q := V / N.

- Повторяет цикл 1-7 1600 раз.

Практика показывает, что такая симуляция выдаёт намного более сильные предсказания, нежели базовая нейросеть.

А дальше ход, который сеть действительно сделает, выбирается одним из двух способов:

— Если это реальная игра, идём туда, где больше N (выяснилось, что такая метрика оказывается самой надёжной);

— Если просто тренировка, выбираем ход из распределения Pi ~ N ^ (1/T), где T — просто некоторая температура для контроля баланса между исследованием и эффективностью.

То, что и policy, и value предсказываются одной общей сетью, даёт возможность крайне эффективно всё это запускать. Мы один раз оказались в какой-то ноде, отдали эту ноду в нашу сеть, получили некоторый результат V, все P запомнили, как изначальные веса на дочерних нодах, и всё, больше для этой ноды сеть не задействуем, сколько бы раз через неё ни ходили, а rollout’ов не запускаем вообще, считая, что предсказанный результат и так достаточно точен. Красота.

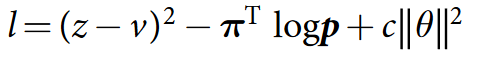

Как тренировать сеть, которая должна предсказывать и policy, и value?

Тренируется всё это дело, используя вот такой лосс:

Что это, Бэрримор?

Формула состоит из трёх частей.

В первой части мы говорим, что сеть должна уметь предсказать результат, то есть z (то, с каким результатом закончилась партия) не должно отличаться от v (того value, которое она предсказала).

Во второй части в качестве лейблов для policy используем наши улучшенные вероятности. Это как reward в supervised learning’е — мы хотим как можно точнее предсказать те вероятности, которые получим, пробегаясь по дереву; очень похоже на cross-entropy loss.

Третья часть, c в конце формулы — просто регуляризатор.

Более глобально, у нас есть некоторая «наилучшая» сеть с весами А. Эта сеть A играет сама с собой 25 000 раз (используя MCTS со своими весами для оценки новых нод), и для каждого хода мы сохраняем сам стейт, распределение Pi и то, чем закончилась игра (+1 за победу и -1 за поражение). Дальше готовим батчи из 2048 случайных позиций из последних 500 000 игр, отдаём 1000 таких батчей на тренировку и получаем некоторую новую сеть с весами B, после чего сеть A играет 400 игр с сетью B — при этом обе сети используют MCTS для выбора хода, только при оценке новой ноды A, очевидно, использует свои веса, а B — свои. Если B побеждает более, чем в 55% случаев, она становится лучшей сетью, если нет — чемпион остаётся прежним. Повторять до готовности.

И ты ещё обещал рассказать про фичи, которые подаются на вход.

Ага, было такое. Итак, на вход подаётся поле 19х19, каждый пиксель которого имеет 17 каналов, итого получаем 19х19х17. 17 слоёв нужны для следующего.

Первый говорит, находится ли в данной точке твой камень или нет (1 — стоит, 0 — отсутствует), а дальнейшие семь — находился ли он тут в какой-то из предыдущих семи ходов.

Зачем это нужно

Дело в том, что в го запрещены повторения — в ряде случаев ты не можешь поставить камень туда, где он уже стоял. Как на картинке:

Не знаю, почему, но хабр иногда отказывается проигрывать эту гифку. Если так и произошло и ты не видишь анимации — просто кликни на неё.

Белые делают ход в точку a и забирают камень чёрных. Чёрные делают ход в точку b и забирают камень белых. Без запрета повторений оппоненты могли бы сидеть и играть последовательность a—b до бесконечности. В реальности же белые не могут сразу повторно сходить в позицию a и должны выбрать другой ход (а вот уже после какого-то иного хода сходить в позицию a разрешено). Именно для того, чтобы сеть могла научиться этому правилу, ей и передают историю. Вторая причина — в АМА на реддите разработчики рассказывали, что когда сеть видит, где в последнее время была активность, она лучше учится. По мысли это чем-то похоже на attention.

Следующие восемь слоёв — то же самое, но для камней оппонента.

Последний, семнадцатый, слой забит единицами, если ты играешь чёрными, и нулями, если играешь белыми. Это нужно, потому что при финальном подсчёте очков белые получают небольшой бонус за то, что ходят вторыми.

Вот и всё, по факту сеть действительно видит только состояние доски, но с информацией о том, камнями какого цвета она играет, и историей на восемь ходов.

А что с архитектурой?

Convolutional layer, потом 40 residual layer’ов, в конце два выхода — value head и policy head. Я не хочу останавливаться на этом подробно, кому важно — посмотрит сам, а всем остальным конкретные слои вряд ли интересны. Если резюмировать, по сравнению с версией Lee сеть стала больше, добавили batch normalization и появились residual connection. Нововведения очень стандартные, очень мейнстримовые, какого-то отдельного rocket science здесь нет.

И всё это чтобы что?

И всё это привело вот к таким результатам.

За три дня AlphaGo Zero учится обыгрывать версию Lee, за 21 — Master, а дальше отправляется в космос. После 40 дней тренировки она обыгрывает версию Lee со счётом 100:0 и версию Master со счётом 89:11. В этом свете интересно отметить, что у Master и Zero идентичный алгоритм тренировки, идентичная архитектура, а все отличия заключаются в фичах, подаваемых на вход, и том, что Zero не тренируется на играх людей. И выигрывает.

То есть всё, компьютер умнее, у человечества шансов нет?

В го — похоже, что да, мы официально в хурме. В общем случае, нет. У го есть несколько особенностей, крайне важных для текущих методов обучения:

- Всегда точно определённая среда, для которой есть идеальный и простой симулятор; никаких случайностей, никаких внешних вмешательств.

- Го — игра с полной информацией. Немножко похоже на предыдущий пункт, но тем не менее — нам известно абсолютно всё, что происходит.

В среде, жёстко ограниченной этими рамками, мы научились строить системы, эффективность которых значительно превышает человеческую. Стоит за рамки немножко выйти, и всё становится сильно сложнее. Поподробнее можно почитать в посте Andrej Karpathy.

А следующий бастион какой?

В играх — Starcraft и DotA. В обоих направлениях ведётся активная работа, но пока без прорывов сравнимого масштаба. Ждём.

Ух! Кажется, немножко понятно. Что ещё можно посмотреть по теме?

Во-первых, посмотри видео в начале этого поста, оно крутое и охватывает многие вопросы, которые я скипнул.

Во-вторых, почитай пост Семёна про AlphaGo Lee.

В-третьих, приходи в канал #data на closedcircles.com, мы там активно всё это обсуждаем.

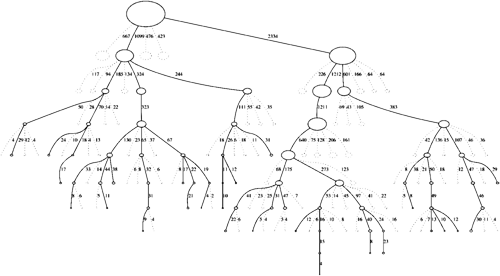

В-четвёртых, всё, что я сейчас рассказал про AGZ, есть на одной картинке.

И давай финалочку.

Я закончу этот пост последним параграфом оригинального пейпера:

Humankind has accumulated Go knowledge from millions of games played over thousands of years, collectively distilled into patterns, proverbs and books. In the space of a few days, starting tabula rasa, AlphaGo Zero was able to rediscover much of this Go knowledge, as well as novel strategies that provide new insights into the oldest of games.

Просто подумай об этом.

Спасибо всем, у кого хватило терпения доскроллить до этого места. Отдельная благодарность пользователям sim0nsays за контент и комментарии и buriy за помощь в вычитке.

This article is about a computer program. For the film, see AlphaGo (film).

AlphaGo is a computer program that plays the board game Go.[1] It was developed by the London-based DeepMind Technologies,[2] an acquired subsidiary of Google (now Alphabet Inc.). Subsequent versions of AlphaGo became increasingly powerful, including a version that competed under the name Master.[3] After retiring from competitive play, AlphaGo Master was succeeded by an even more powerful version known as AlphaGo Zero, which was completely self-taught without learning from human games. AlphaGo Zero was then generalized into a program known as AlphaZero, which played additional games, including chess and shogi. AlphaZero has in turn been succeeded by a program known as MuZero which learns without being taught the rules.

AlphaGo and its successors use a Monte Carlo tree search algorithm to find its moves based on knowledge previously acquired by machine learning, specifically by an artificial neural network (a deep learning method) by extensive training, both from human and computer play.[4] A neural network is trained to identify the best moves and the winning percentages of these moves. This neural network improves the strength of the tree search, resulting in stronger move selection in the next iteration.

In October 2015, in a match against Fan Hui, the original AlphaGo became the first computer Go program to beat a human professional Go player without handicap on a full-sized 19×19 board.[5][6] In March 2016, it beat Lee Sedol in a five-game match, the first time a computer Go program has beaten a 9-dan professional without handicap.[7] Although it lost to Lee Sedol in the fourth game, Lee resigned in the final game, giving a final score of 4 games to 1 in favour of AlphaGo. In recognition of the victory, AlphaGo was awarded an honorary 9-dan by the Korea Baduk Association.[8] The lead up and the challenge match with Lee Sedol were documented in a documentary film also titled AlphaGo,[9] directed by Greg Kohs. The win by AlphaGo was chosen by Science as one of the Breakthrough of the Year runners-up on 22 December 2016.[10]

At the 2017 Future of Go Summit, the Master version of AlphaGo beat Ke Jie, the number one ranked player in the world at the time, in a three-game match, after which AlphaGo was awarded professional 9-dan by the Chinese Weiqi Association.[11]

After the match between AlphaGo and Ke Jie, DeepMind retired AlphaGo, while continuing AI research in other areas.[12] The self-taught AlphaGo Zero achieved a 100–0 victory against the early competitive version of AlphaGo, and its successor AlphaZero is currently perceived as the world’s top player in Go.[13][14]

History[edit]

Go is considered much more difficult for computers to win than other games such as chess, because its strategic and aesthetic nature makes it hard to directly construct an evaluation function, and its much larger branching factor makes it prohibitively difficult to use traditional AI methods such as alpha–beta pruning, tree traversal and heuristic search.[5][15]

Almost two decades after IBM’s computer Deep Blue beat world chess champion Garry Kasparov in the 1997 match, the strongest Go programs using artificial intelligence techniques only reached about amateur 5-dan level,[4] and still could not beat a professional Go player without a handicap.[5][6][16] In 2012, the software program Zen, running on a four PC cluster, beat Masaki Takemiya (9p) twice at five- and four-stone handicaps.[17] In 2013, Crazy Stone beat Yoshio Ishida (9p) at a four-stone handicap.[18]

According to DeepMind’s David Silver, the AlphaGo research project was formed around 2014 to test how well a neural network using deep learning can compete at Go.[19] AlphaGo represents a significant improvement over previous Go programs. In 500 games against other available Go programs, including Crazy Stone and Zen, AlphaGo running on a single computer won all but one.[20] In a similar matchup, AlphaGo running on multiple computers won all 500 games played against other Go programs, and 77% of games played against AlphaGo running on a single computer. The distributed version in October 2015 was using 1,202 CPUs and 176 GPUs.[4]

Match against Fan Hui[edit]

In October 2015, the distributed version of AlphaGo defeated the European Go champion Fan Hui,[21] a 2-dan (out of 9 dan possible) professional, five to zero.[6][22] This was the first time a computer Go program had beaten a professional human player on a full-sized board without handicap.[23] The announcement of the news was delayed until 27 January 2016 to coincide with the publication of a paper in the journal Nature[4] describing the algorithms used.[6]

Match against Lee Sedol[edit]

AlphaGo played South Korean professional Go player Lee Sedol, ranked 9-dan, one of the best players at Go,[16][needs update] with five games taking place at the Four Seasons Hotel in Seoul, South Korea on 9, 10, 12, 13, and 15 March 2016,[24][25] which were video-streamed live.[26] Out of five games, AlphaGo won four games and Lee won the fourth game which made him recorded as the only human player who beat AlphaGo in all of its 74 official games.[27] AlphaGo ran on Google’s cloud computing with its servers located in the United States.[28] The match used Chinese rules with a 7.5-point komi, and each side had two hours of thinking time plus three 60-second byoyomi periods.[29] The version of AlphaGo playing against Lee used a similar amount of computing power as was used in the Fan Hui match.[30] The Economist reported that it used 1,920 CPUs and 280 GPUs.[31] At the time of play, Lee Sedol had the second-highest number of Go international championship victories in the world after South Korean player Lee Changho who kept the world championship title for 16 years.[32] Since there is no single official method of ranking in international Go, the rankings may vary among the sources. While he was ranked top sometimes, some sources ranked Lee Sedol as the fourth-best player in the world at the time.[33][34] AlphaGo was not specifically trained to face Lee nor was designed to compete with any specific human players.

The first three games were won by AlphaGo following resignations by Lee.[35][36] However, Lee beat AlphaGo in the fourth game, winning by resignation at move 180. AlphaGo then continued to achieve a fourth win, winning the fifth game by resignation.[37]

The prize was US$1 million. Since AlphaGo won four out of five and thus the series, the prize will be donated to charities, including UNICEF.[38] Lee Sedol received $150,000 for participating in all five games and an additional $20,000 for his win in Game 4.[29]

In June 2016, at a presentation held at a university in the Netherlands, Aja Huang, one of the Deep Mind team, revealed that they had patched the logical weakness that occurred during the 4th game of the match between AlphaGo and Lee, and that after move 78 (which was dubbed the «divine move» by many professionals), it would play as intended and maintain Black’s advantage. Before move 78, AlphaGo was leading throughout the game, but Lee’s move caused the program’s computing powers to be diverted and confused.[39] Huang explained that AlphaGo’s policy network of finding the most accurate move order and continuation did not precisely guide AlphaGo to make the correct continuation after move 78, since its value network did not determine Lee’s 78th move as being the most likely, and therefore when the move was made AlphaGo could not make the right adjustment to the logical continuation.[40]

Sixty online games[edit]

On 29 December 2016, a new account on the Tygem server named «Magister» (shown as ‘Magist’ at the server’s Chinese version) from South Korea began to play games with professional players. It changed its account name to «Master» on 30 December, then moved to the FoxGo server on 1 January 2017. On 4 January, DeepMind confirmed that the «Magister» and the «Master» were both played by an updated version of AlphaGo, called AlphaGo Master.[41][42] As of 5 January 2017, AlphaGo Master’s online record was 60 wins and 0 losses,[43] including three victories over Go’s top-ranked player, Ke Jie,[44] who had been quietly briefed in advance that Master was a version of AlphaGo.[43] After losing to Master, Gu Li offered a bounty of 100,000 yuan (US$14,400) to the first human player who could defeat Master.[42] Master played at the pace of 10 games per day. Many quickly suspected it to be an AI player due to little or no resting between games. Its adversaries included many world champions such as Ke Jie, Park Jeong-hwan, Yuta Iyama, Tuo Jiaxi, Mi Yuting, Shi Yue, Chen Yaoye, Li Qincheng, Gu Li, Chang Hao, Tang Weixing, Fan Tingyu, Zhou Ruiyang, Jiang Weijie, Chou Chun-hsun, Kim Ji-seok, Kang Dong-yun, Park Yeong-hun, and Won Seong-jin; national champions or world championship runners-up such as Lian Xiao, Tan Xiao, Meng Tailing, Dang Yifei, Huang Yunsong, Yang Dingxin, Gu Zihao, Shin Jinseo, Cho Han-seung, and An Sungjoon. All 60 games except one were fast-paced games with three 20 or 30 seconds byo-yomi. Master offered to extend the byo-yomi to one minute when playing with Nie Weiping in consideration of his age. After winning its 59th game Master revealed itself in the chatroom to be controlled by Dr. Aja Huang of the DeepMind team,[45] then changed its nationality to the United Kingdom. After these games were completed, the co-founder of DeepMind, Demis Hassabis, said in a tweet, «we’re looking forward to playing some official, full-length games later [2017] in collaboration with Go organizations and experts».[41][42]

Go experts were impressed by the program’s performance and its nonhuman play style; Ke Jie stated that «After humanity spent thousands of years improving our tactics, computers tell us that humans are completely wrong… I would go as far as to say not a single human has touched the edge of the truth of Go.»[43]

Future of Go Summit[edit]

In the Future of Go Summit held in Wuzhen in May 2017, AlphaGo Master played three games with Ke Jie, the world No.1 ranked player, as well as two games with several top Chinese professionals, one pair Go game and one against a collaborating team of five human players.[46]

Google DeepMind offered 1.5 million dollar winner prizes for the three-game match between Ke Jie and Master while the losing side took 300,000 dollars.[47][48] Master won all three games against Ke Jie,[49][50] after which AlphaGo was awarded professional 9-dan by the Chinese Weiqi Association.[11]

After winning its three-game match against Ke Jie, the top-rated world Go player, AlphaGo retired. DeepMind also disbanded the team that worked on the game to focus on AI research in other areas.[12] After the Summit, Deepmind published 50 full length AlphaGo vs AlphaGo matches, as a gift to the Go community.[51]

AlphaGo Zero and AlphaZero[edit]

AlphaGo’s team published an article in the journal Nature on 19 October 2017, introducing AlphaGo Zero, a version without human data and stronger than any previous human-champion-defeating version.[52] By playing games against itself, AlphaGo Zero surpassed the strength of AlphaGo Lee in three days by winning 100 games to 0, reached the level of AlphaGo Master in 21 days, and exceeded all the old versions in 40 days.[53]

In a paper released on arXiv on 5 December 2017, DeepMind claimed that it generalized AlphaGo Zero’s approach into a single AlphaZero algorithm, which achieved within 24 hours a superhuman level of play in the games of chess, shogi, and Go by defeating world-champion programs, Stockfish, Elmo, and 3-day version of AlphaGo Zero in each case.[54]

Teaching tool[edit]

On 11 December 2017, DeepMind released AlphaGo teaching tool on its website[55] to analyze winning rates of different Go openings as calculated by AlphaGo Master.[56] The teaching tool collects 6,000 Go openings from 230,000 human games each analyzed with 10,000,000 simulations by AlphaGo Master. Many of the openings include human move suggestions.[56]

Versions[edit]

An early version of AlphaGo was tested on hardware with various numbers of CPUs and GPUs, running in asynchronous or distributed mode. Two seconds of thinking time was given to each move. The resulting Elo ratings are listed below.[4] In the matches with more time per move higher ratings are achieved.

| Configuration | Search threads |

No. of CPU | No. of GPU | Elo rating |

|---|---|---|---|---|

| Single[4] p. 10–11 | 40 | 48 | 1 | 2,181 |

| Single | 40 | 48 | 2 | 2,738 |

| Single | 40 | 48 | 4 | 2,850 |

| Single | 40 | 48 | 8 | 2,890 |

| Distributed | 12 | 428 | 64 | 2,937 |

| Distributed | 24 | 764 | 112 | 3,079 |

| Distributed | 40 | 1,202 | 176 | 3,140 |

| Distributed | 64 | 1,920 | 280 | 3,168 |

In May 2016, Google unveiled its own proprietary hardware «tensor processing units», which it stated had already been deployed in multiple internal projects at Google, including the AlphaGo match against Lee Sedol.[57][58]

In the Future of Go Summit in May 2017, DeepMind disclosed that the version of AlphaGo used in this Summit was AlphaGo Master,[59][60] and revealed that it had measured the strength of different versions of the software. AlphaGo Lee, the version used against Lee, could give AlphaGo Fan, the version used in AlphaGo vs. Fan Hui, three stones, and AlphaGo Master was even three stones stronger.[61]

| Versions | Hardware | Elo rating | Date | Results |

|---|---|---|---|---|

| AlphaGo Fan | 176 GPUs,[53] distributed | 3,144[52] | Oct 2015 | 5:0 against Fan Hui |

| AlphaGo Lee | 48 TPUs,[53] distributed | 3,739[52] | Mar 2016 | 4:1 against Lee Sedol |

| AlphaGo Master | 4 TPUs,[53] single machine | 4,858[52] | May 2017 | 60:0 against professional players; Future of Go Summit |

| AlphaGo Zero (40 block) | 4 TPUs,[53] single machine | 5,185[52] | Oct 2017 | 100:0 against AlphaGo Lee

89:11 against AlphaGo Master |

| AlphaZero (20 block) | 4 TPUs, single machine | 5,018

[63] |

Dec 2017 | 60:40 against AlphaGo Zero (20 block) |

Algorithm[edit]

As of 2016, AlphaGo’s algorithm uses a combination of machine learning and tree search techniques, combined with extensive training, both from human and computer play. It uses Monte Carlo tree search, guided by a «value network» and a «policy network,» both implemented using deep neural network technology.[5][4] A limited amount of game-specific feature detection pre-processing (for example, to highlight whether a move matches a nakade pattern) is applied to the input before it is sent to the neural networks.[4] The networks are convolutional neural networks with 12 layers, trained by reinforcement learning.[64]

The system’s neural networks were initially bootstrapped from human gameplay expertise. AlphaGo was initially trained to mimic human play by attempting to match the moves of expert players from recorded historical games, using a database of around 30 million moves.[21] Once it had reached a certain degree of proficiency, it was trained further by being set to play large numbers of games against other instances of itself, using reinforcement learning to improve its play.[5] To avoid «disrespectfully» wasting its opponent’s time, the program is specifically programmed to resign if its assessment of win probability falls beneath a certain threshold; for the match against Lee, the resignation threshold was set to 20%.[65]

Style of play[edit]

Toby Manning, the match referee for AlphaGo vs. Fan Hui, has described the program’s style as «conservative».[66] AlphaGo’s playing style strongly favours greater probability of winning by fewer points over lesser probability of winning by more points.[19] Its strategy of maximising its probability of winning is distinct from what human players tend to do which is to maximise territorial gains, and explains some of its odd-looking moves.[67] It makes a lot of opening moves that have never or seldom been made by humans. It likes to use shoulder hits, especially if the opponent is over concentrated.[citation needed]

Responses to 2016 victory[edit]

[edit]

AlphaGo’s March 2016 victory was a major milestone in artificial intelligence research.[68] Go had previously been regarded as a hard problem in machine learning that was expected to be out of reach for the technology of the time.[68][69][70] Most experts thought a Go program as powerful as AlphaGo was at least five years away;[71] some experts thought that it would take at least another decade before computers would beat Go champions.[4][72][73] Most observers at the beginning of the 2016 matches expected Lee to beat AlphaGo.[68]

With games such as checkers (that has been «solved» by the Chinook draughts player team), chess, and now Go won by computers, victories at popular board games can no longer serve as major milestones for artificial intelligence in the way that they used to. Deep Blue’s Murray Campbell called AlphaGo’s victory «the end of an era… board games are more or less done and it’s time to move on.»[68]

When compared with Deep Blue or Watson, AlphaGo’s underlying algorithms are potentially more general-purpose and may be evidence that the scientific community is making progress towards artificial general intelligence.[19][74] Some commentators believe AlphaGo’s victory makes for a good opportunity for society to start preparing for the possible future impact of machines with general purpose intelligence. As noted by entrepreneur Guy Suter, AlphaGo only knows how to play Go and doesn’t possess general-purpose intelligence; «[It] couldn’t just wake up one morning and decide it wants to learn how to use firearms.»[68] AI researcher Stuart Russell said that AI systems such as AlphaGo have progressed quicker and become more powerful than expected, and we must therefore develop methods to ensure they «remain under human control».[75] Some scholars, such as Stephen Hawking, warned (in May 2015 before the matches) that some future self-improving AI could gain actual general intelligence, leading to an unexpected AI takeover; other scholars disagree: AI expert Jean-Gabriel Ganascia believes that «Things like ‘common sense’… may never be reproducible»,[76] and says «I don’t see why we would speak about fears. On the contrary, this raises hopes in many domains such as health and space exploration.»[75] Computer scientist Richard Sutton said «I don’t think people should be scared… but I do think people should be paying attention.»[77]

In China, AlphaGo was a «Sputnik moment» which helped convince the Chinese government to prioritize and dramatically increase funding for artificial intelligence.[78]

In 2017, the DeepMind AlphaGo team received the inaugural IJCAI Marvin Minsky medal for Outstanding Achievements in AI. «AlphaGo is a wonderful achievement, and a perfect example of what the Minsky Medal was initiated to recognise», said Professor Michael Wooldridge, Chair of the IJCAI Awards Committee. «What particularly impressed IJCAI was that AlphaGo achieves what it does through a brilliant combination of classic AI techniques as well as the state-of-the-art machine learning techniques that DeepMind is so closely associated with. It’s a breathtaking demonstration of contemporary AI, and we are delighted to be able to recognise it with this award.»[79]

[edit]

Go is a popular game in China, Japan and Korea, and the 2016 matches were watched by perhaps a hundred million people worldwide.[68][80] Many top Go players characterized AlphaGo’s unorthodox plays as seemingly-questionable moves that initially befuddled onlookers, but made sense in hindsight:[72] «All but the very best Go players craft their style by imitating top players. AlphaGo seems to have totally original moves it creates itself.»[68] AlphaGo appeared to have unexpectedly become much stronger, even when compared with its October 2015 match[81] where a computer had beaten a Go professional for the first time ever without the advantage of a handicap.[82] The day after Lee’s first defeat, Jeong Ahram, the lead Go correspondent for one of South Korea’s biggest daily newspapers, said «Last night was very gloomy… Many people drank alcohol.»[83] The Korea Baduk Association, the organization that oversees Go professionals in South Korea, awarded AlphaGo an honorary 9-dan title for exhibiting creative skills and pushing forward the game’s progress.[84]

China’s Ke Jie, an 18-year-old generally recognized as the world’s best Go player at the time,[33][85] initially claimed that he would be able to beat AlphaGo, but declined to play against it for fear that it would «copy my style».[85] As the matches progressed, Ke Jie went back and forth, stating that «it is highly likely that I (could) lose» after analysing the first three matches,[86] but regaining confidence after AlphaGo displayed flaws in the fourth match.[87]

Toby Manning, the referee of AlphaGo’s match against Fan Hui, and Hajin Lee, secretary general of the International Go Federation, both reason that in the future, Go players will get help from computers to learn what they have done wrong in games and improve their skills.[82]

After game two, Lee said he felt «speechless»: «From the very beginning of the match, I could never manage an upper hand for one single move. It was AlphaGo’s total victory.»[88] Lee apologized for his losses, stating after game three that «I misjudged the capabilities of AlphaGo and felt powerless.»[68] He emphasized that the defeat was «Lee Se-dol’s defeat» and «not a defeat of mankind».[27][76] Lee said his eventual loss to a machine was «inevitable» but stated that «robots will never understand the beauty of the game the same way that we humans do.»[76] Lee called his game four victory a «priceless win that I (would) not exchange for anything.»[27]

Similar systems[edit]

Facebook has also been working on its own Go-playing system darkforest, also based on combining machine learning and Monte Carlo tree search.[66][89] Although a strong player against other computer Go programs, as of early 2016, it had not yet defeated a professional human player.[90] Darkforest has lost to CrazyStone and Zen and is estimated to be of similar strength to CrazyStone and Zen.[91]

DeepZenGo, a system developed with support from video-sharing website Dwango and the University of Tokyo, lost 2–1 in November 2016 to Go master Cho Chikun, who holds the record for the largest number of Go title wins in Japan.[92][93]

A 2018 paper in Nature cited AlphaGo’s approach as the basis for a new means of computing potential pharmaceutical drug molecules.[94][95]

Example game[edit]

AlphaGo Master (white) v. Tang Weixing (31 December 2016), AlphaGo won by resignation. White 36 was widely praised.

Impacts on Go[edit]

The documentary film AlphaGo[9][96] raised hopes that Lee Sedol and Fan Hui would have benefitted from their experience of playing AlphaGo, but as of May 2018 their ratings were little changed; Lee Sedol was ranked 11th in the world, and Fan Hui 545th.[97] On 19 November 2019, Lee announced his retirement from professional play, arguing that he could never be the top overall player of Go due to the increasing dominance of AI. Lee referred to them as being «an entity that cannot be defeated».[98]

See also[edit]

- Albert Lindsey Zobrist, wrote first Go program in 1968

- Chinook (draughts player), draughts playing program

- Glossary of artificial intelligence

- Go and mathematics

- Leela (software)

- Leela Zero, open-source learning Go program

- Matchbox Educable Noughts and Crosses Engine

- Samuel’s learning computer checkers (draughts)

- TD-Gammon, backgammon neural network

- Pluribus (poker bot)

- AlphaZero

- AlphaFold

References[edit]

- ^ «Artificial intelligence: Google’s AlphaGo beats Go master Lee Se-dol». BBC News. 12 March 2016. Retrieved 17 March 2016.

- ^ «DeepMind AlphaGO». DeepMind Artificial Intelligence AlphaGo.

- ^ «AlphaGo | DeepMind». DeepMind.

- ^ a b c d e f g h i Silver, David; Huang, Aja; Maddison, Chris J.; Guez, Arthur; Sifre, Laurent; Driessche, George van den; Schrittwieser, Julian; Antonoglou, Ioannis; Panneershelvam, Veda; Lanctot, Marc; Dieleman, Sander; Grewe, Dominik; Nham, John; Kalchbrenner, Nal; Sutskever, Ilya; Lillicrap, Timothy; Leach, Madeleine; Kavukcuoglu, Koray; Graepel, Thore; Hassabis, Demis (28 January 2016). «Mastering the game of Go with deep neural networks and tree search». Nature. 529 (7587): 484–489. Bibcode:2016Natur.529..484S. doi:10.1038/nature16961. ISSN 0028-0836. PMID 26819042. S2CID 515925.

- ^ a b c d e «Research Blog: AlphaGo: Mastering the ancient game of Go with Machine Learning». Google Research Blog. 27 January 2016.

- ^ a b c d «Google achieves AI ‘breakthrough’ by beating Go champion». BBC News. 27 January 2016.

- ^ «Match 1 – Google DeepMind Challenge Match: Lee Sedol vs AlphaGo». YouTube. 8 March 2016.

- ^ «Google’s AlphaGo gets ‘divine’ Go ranking». The Straits Times. straitstimes.com. 15 March 2016. Retrieved 9 December 2017.

- ^ a b «AlphaGo Movie». AlphaGo Movie.

- ^ «From AI to protein folding: Our Breakthrough runners-up». Science. 22 December 2016. Retrieved 29 December 2016.

- ^ a b «中国围棋协会授予AlphaGo职业九段 并颁发证书» (in Chinese). Sohu.com. 27 May 2017. Retrieved 9 December 2017.

- ^ a b Metz, Cade (27 May 2017). «After Win in China, AlphaGo’s Designers Explore New AI». Wired.

- ^ «AlphaZero Crushes Stockfish In New 1,000-Game Match». 17 April 2019.

- ^ Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent; Kumaran, Dharshan; Graepel, Thore; Lillicrap, Timothy; Simonyan, Karen; Hassabis, Demis (7 December 2018). «A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play». Science. 362 (6419): 1140–1144. Bibcode:2018Sci…362.1140S. doi:10.1126/science.aar6404. PMID 30523106. S2CID 54457125.

- ^ Schraudolph, Nicol N.; Terrence, Peter Dayan; Sejnowski, J., Temporal Difference Learning of Position Evaluation in the Game of Go (PDF)

- ^ a b «Computer scores big win against humans in ancient game of Go». CNN. 28 January 2016. Retrieved 28 January 2016.

- ^ «Zen computer Go program beats Takemiya Masaki with just 4 stones!». Go Game Guru. Archived from the original on 1 February 2016. Retrieved 28 January 2016.

- ^ «「アマ六段の力。天才かも」囲碁棋士、コンピューターに敗れる 初の公式戦». MSN Sankei News. Archived from the original on 24 March 2013. Retrieved 27 March 2013.

- ^ a b c John Riberio (14 March 2016). «AlphaGo’s unusual moves prove its AI prowess, experts say». PC World. Retrieved 18 March 2016.

- ^ «Google AlphaGo AI clean sweeps European Go champion». ZDNet. 28 January 2016. Retrieved 28 January 2016.

- ^ a b Metz, Cade (27 January 2016). «In Major AI Breakthrough, Google System Secretly Beats Top Player at the Ancient Game of Go». WIRED. Retrieved 1 February 2016.

- ^ «Special Computer Go insert covering the AlphaGo v Fan Hui match» (PDF). British Go Journal. 2017. Retrieved 1 February 2016.

- ^ «Première défaite d’un professionnel du go contre une intelligence artificielle». Le Monde (in French). 27 January 2016.

- ^ «Google’s AI AlphaGo to take on world No 1 Lee Sedol in live broadcast». The Guardian. 5 February 2016. Retrieved 15 February 2016.

- ^ «Google DeepMind is going to take on the world’s best Go player in a luxury 5-star hotel in South Korea». Business Insider. 22 February 2016. Retrieved 23 February 2016.

- ^ Novet, Jordan (4 February 2016). «YouTube will livestream Google’s AI playing Go superstar Lee Sedol in March». VentureBeat. Retrieved 7 February 2016.

- ^ a b c Yoon Sung-won (14 March 2016). «Lee Se-dol shows AlphaGo beatable». The Korea Times. Retrieved 15 March 2016.

- ^ «李世乭:即使Alpha Go得到升级也一样能赢». JoongAng Ilbo (in Chinese). 23 February 2016. Retrieved 24 February 2016.

- ^ a b «이세돌 vs 알파고, ‘구글 딥마인드 챌린지 매치’ 기자회견 열려» (in Korean). Korea Baduk Association. 22 February 2016. Archived from the original on 3 March 2016. Retrieved 22 February 2016.

- ^ Demis Hassabis [@demishassabis] (11 March 2016). «We are using roughly same amount of compute power as in Fan Hui match: distributing search over further machines has diminishing returns» (Tweet). Retrieved 14 March 2016 – via Twitter.

- ^ «Showdown». The Economist. Retrieved 19 November 2016.

- ^ Steven Borowiec (9 March 2016). «Google’s AI machine v world champion of ‘Go’: everything you need to know». The Guardian. Retrieved 15 March 2016.

- ^ a b Rémi Coulom. «Rating List of 2016-01-01». Archived from the original on 18 March 2016. Retrieved 18 March 2016.

- ^ «Korean Go master proves human intuition still powerful in Go». The Korean Herald/ANN. 14 March 2016. Archived from the original on 12 April 2016. Retrieved 15 March 2016.

- ^ «Google’s AI beats world Go champion in first of five matches – BBC News». BBC Online. Retrieved 9 March 2016.

- ^ «Google AI wins second Go game against world champion – BBC News». BBC Online. Retrieved 10 March 2016.

- ^ «Google DeepMind AI wins final Go match for 4–1 series win». Engadget. Retrieved 15 March 2016.

- ^ «Human champion certain he’ll beat AI at ancient Chinese game». Associated Press. 22 February 2016. Retrieved 22 February 2016.

- ^ «In Two Moves, AlphaGo and Lee Sedol Redefined the Future». WIRED. Retrieved 12 November 2017.

- ^ «黄士杰:AlphaGo李世石人机大战第四局问题已解决date=8 July 2016» (in Chinese). Retrieved 8 July 2016.

- ^ a b Demis Hassabis (4 January 2017). «Demis Hassabis on Twitter: «Excited to share an update on #AlphaGo!»«. Demis Hassabis’s Twitter account. Retrieved 4 January 2017.

- ^ a b c Elizabeth Gibney (4 January 2017). «Google reveals secret test of AI bot to beat top Go players». Nature. 541 (7636): 142. Bibcode:2017Natur.541..142G. doi:10.1038/nature.2017.21253. PMID 28079098.

- ^ a b c «Humans Mourn Loss After Google Is Unmasked as China’s Go Master». Wall Street Journal. 5 January 2017. Retrieved 6 January 2017.

- ^ «The world’s best Go player says he still has «one last move» to defeat Google’s AlphaGo AI». Quartz. 4 January 2017. Retrieved 6 January 2017.

- ^ «横扫中日韩棋手斩获59胜的Master发话:我是阿尔法狗» (in Chinese). 澎湃新闻. 4 January 2017. Retrieved 11 December 2017.

- ^ «Exploring the mysteries of Go with AlphaGo and China’s top players». 10 April 2017.

- ^ «World No.1 Go player Ke Jie takes on upgraded AlphaGo in May». 10 April 2017.

- ^ «Ke Jie vs. AlphaGo: 8 things you must know». 27 May 2017.

- ^ Metz, Cade (23 May 2017). «Revamped AlphaGo Wins First Game Against Chinese Go Grandmaster». Wired.

- ^ Metz, Cade (25 May 2017). «Google’s AlphaGo Continues Dominance With Second Win in China». Wired.

- ^ «Full length games for Go players to enjoy». Deepmind. Retrieved 28 May 2017.

- ^ a b c d e Silver, David; Schrittwieser, Julian; Simonyan, Karen; Antonoglou, Ioannis; Huang, Aja; Guez, Arthur; Hubert, Thomas; Baker, Lucas; Lai, Matthew; Bolton, Adrian; Chen, Yutian; Lillicrap, Timothy; Fan, Hui; Sifre, Laurent; Driessche, George van den; Graepel, Thore; Hassabis, Demis (19 October 2017). «Mastering the game of Go without human knowledge» (PDF). Nature. 550 (7676): 354–359. Bibcode:2017Natur.550..354S. doi:10.1038/nature24270. ISSN 0028-0836. PMID 29052630. S2CID 205261034.

- ^ a b c d e «AlphaGo Zero: Learning from scratch». DeepMind official website. 18 October 2017. Retrieved 19 October 2017.

- ^ Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent; Kumaran, Dharshan; Graepel, Thore; Lillicrap, Timothy; Simonyan, Karen; Hassabis, Demis (5 December 2017). «Mastering Chess and Shogi by Self-Play with a General Reinforcement Learning Algorithm». arXiv:1712.01815 [cs.AI].

- ^ «AlphaGo teaching tool». DeepMind.

- ^ a b «AlphaGo教学工具上线 樊麾:使用Master版本» (in Chinese). Sina.com.cn. 11 December 2017. Retrieved 11 December 2017.

- ^ McMillan, Robert (18 May 2016). «Google Isn’t Playing Games With New Chip». The Wall Street Journal. Retrieved 26 June 2016.

- ^ Jouppi, Norm (18 May 2016). «Google supercharges machine learning tasks with TPU custom chip». Google Cloud Platform Blog. Retrieved 26 June 2016.

- ^ «AlphaGo官方解读让三子 对人类高手没这种优势» (in Chinese). Sina. 25 May 2017. Retrieved 2 June 2017.

- ^ «各版alphago实力对比 master能让李世石版3子» (in Chinese). Sina. 24 May 2017. Retrieved 2 June 2017.

- ^ «New version of AlphaGo self-trained and much more efficient». American Go Association. 24 May 2017. Retrieved 1 June 2017.

- ^ «【柯洁战败解密】AlphaGo Master最新架构和算法,谷歌云与TPU拆解» (in Chinese). Sohu. 24 May 2017. Retrieved 1 June 2017.

- ^ Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent; Kumaran, Dharshan; Graepel, Thore; Lillicrap, Timothy; Simonyan, Karen; Hassabis, Demis (7 December 2018). «A general reinforcement learning algorithm that masters chess, shogi, and Go through self-play». Science. 362 (6419): 1140–1144. Bibcode:2018Sci…362.1140S. doi:10.1126/science.aar6404. PMID 30523106. S2CID 54457125 – via science.org (Atypon).

- ^ Silver, David; Schrittwieser, Julian; Simonyan, Karen; Antonoglou, Ioannis; Huang, Aja; Guez, Arthur; Hubert, Thomas; Baker, Lucas; Lai, Matthew; Bolton, Adrian; Chen, Yutian; Lillicrap, Timothy; Fan, Hui; Sifre, Laurent; Driessche, George van den; Graepel, Thore; Hassabis, Demis (19 October 2017). «Mastering the game of Go without human knowledge» (PDF). Nature. 550 (7676): 354–359. Bibcode:2017Natur.550..354S. doi:10.1038/nature24270. ISSN 0028-0836. PMID 29052630. S2CID 205261034.

AlphaGo Lee… 12 convolutional layers

- ^ Cade Metz (13 March 2016). «Go Grandmaster Lee Sedol Grabs Consolation Win Against Google’s AI». Wired News. Retrieved 29 March 2016.

- ^ a b Gibney, Elizabeth (27 January 2016). «Google AI algorithm masters ancient game of Go». Nature. 529 (7587): 445–6. Bibcode:2016Natur.529..445G. doi:10.1038/529445a. PMID 26819021.

- ^ Chouard, Tanguy (12 March 2016). «The Go Files: AI computer clinches victory against Go champion». Nature. doi:10.1038/nature.2016.19553. S2CID 155164502.

- ^ a b c d e f g h Steven Borowiec; Tracey Lien (12 March 2016). «AlphaGo beats human Go champ in milestone for artificial intelligence». Los Angeles Times. Retrieved 13 March 2016.

- ^ Connor, Steve (27 January 2016). «A computer has beaten a professional at the world’s most complex board game». The Independent. Archived from the original on 28 January 2016. Retrieved 28 January 2016.

- ^ «Google’s AI beats human champion at Go». CBC News. 27 January 2016. Retrieved 28 January 2016.

- ^ Dave Gershgorn (12 March 2016). «GOOGLE’S ALPHAGO BEATS WORLD CHAMPION IN THIRD MATCH TO WIN ENTIRE SERIES». Popular Science. Retrieved 13 March 2016.

- ^ a b «Google DeepMind computer AlphaGo sweeps human champ in Go matches». CBC News. Associated Press. 12 March 2016. Retrieved 13 March 2016.

- ^ Sofia Yan (12 March 2016). «A Google computer victorious over the world’s ‘Go’ champion». CNN Money. Retrieved 13 March 2016.

- ^ «AlphaGo: Google’s artificial intelligence to take on world champion of ancient Chinese board game». Australian Broadcasting Corporation. 8 March 2016. Retrieved 13 March 2016.

- ^ a b Mariëtte Le Roux (12 March 2016). «Rise of the Machines: Keep an eye on AI, experts warn». Phys.org. Retrieved 13 March 2016.

- ^ a b c Mariëtte Le Roux; Pascale Mollard (8 March 2016). «Game over? New AI challenge to human smarts (Update)». phys.org. Retrieved 13 March 2016.

- ^ Tanya Lewis (11 March 2016). «An AI expert says Google’s Go-playing program is missing 1 key feature of human intelligence». Business Insider. Retrieved 13 March 2016.

- ^ Mozur, Paul (20 July 2017). «Beijing Wants A.I. to Be Made in China by 2030». The New York Times. Retrieved 11 April 2018.

- ^ «Marvin Minsky Medal for Outstanding Achievements in AI». International Joint Conference on Artificial Intelligence. 19 October 2017. Retrieved 21 October 2017.

- ^ CHOE SANG-HUN (16 March 2016). «Google’s Computer Program Beats Lee Se-dol in Go Tournament». The New York Times. Retrieved 18 March 2016.

More than 100 million people watched the AlphaGo-Lee matches, Mr. Hassabis said.

- ^ John Ribeiro (12 March 2016). «Google’s AlphaGo AI program strong but not perfect, says defeated South Korean Go player». PC World. Retrieved 13 March 2016.

- ^ a b Gibney, Elizabeth (2016). «Go players react to computer defeat». Nature. doi:10.1038/nature.2016.19255. S2CID 146868978.

- ^ Zastrow, Mark (15 March 2016). «How victory for Google’s Go AI is stoking fear in South Korea». New Scientist. Retrieved 18 March 2016.

- ^ JEE HEUN KAHNG; SE YOUNG LEE (15 March 2016). «Google artificial intelligence program beats S. Korean Go pro with 4–1 score». Reuters. Retrieved 18 March 2016.

- ^ a b Neil Connor (11 March 2016). «Google AlphaGo ‘can’t beat me’ says China Go grandmaster». The Telegraph (UK). Retrieved 13 March 2016.

- ^ «Chinese Go master Ke Jie says he could lose to AlphaGo : The DONG-A ILBO». Retrieved 17 March 2016.

- ^ «…if today’s performance was its true capability, then it doesn’t deserve to play against me». M.hankooki.com. 14 March 2016. Retrieved 5 June 2018.

- ^ CHOE SANG-HUN (15 March 2016). «In Seoul, Go Games Spark Interest (and Concern) About Artificial Intelligence». The New York Times. Retrieved 18 March 2016.

- ^ Tian, Yuandong; Zhu, Yan (2015). «Better Computer Go Player with Neural Network and Long-term Prediction». arXiv:1511.06410v1 [cs.LG].

- ^ HAL 90210 (28 January 2016). «No Go: Facebook fails to spoil Google’s big AI day». The Guardian. ISSN 0261-3077. Retrieved 1 February 2016.

- ^ «Strachey Lecture – Dr Demis Hassabis». The New Livestream. Retrieved 17 March 2016.

- ^ «Go master Cho wins best-of-three series against Japan-made AI». The Japan Times Online. 24 November 2016. Retrieved 27 November 2016.

- ^ «Humans strike back: Korean Go master bests AI in board game bout». CNET. Retrieved 27 November 2016.

- ^ «Go and make some drugs The Engineer». www.theengineer.co.uk. 3 April 2018. Retrieved 3 April 2018.

- ^ Segler, Martwin H.S.; Preuss, Mike; Waller, Mark P. (29 March 2018). «Planning chemical syntheses with deep neural networks and symbolic AI». Nature. 555 (7698): 604–610. arXiv:1708.04202. Bibcode:2018Natur.555..604S. doi:10.1038/nature25978. PMID 29595767. S2CID 205264340.

- ^ «AlphaGo (2017)». Rotten Tomatoes. Retrieved 5 June 2018.

- ^ «Go Ratings». Go Ratings. Retrieved 5 June 2018.

- ^ Vincent, James (27 November 2019). «Former Go champion beaten by DeepMind retires after declaring AI invincible». The Verge. Retrieved 28 November 2019.

External links[edit]

Искусственный интеллект, который воспроизводит Go

AlphaGo — это компьютерная программа, которая играет в настольную игру Go. Он был разработан DeepMind Technologies, которая позже была приобретена Google. Последующие версии AlphaGo становились все более мощными, в том числе версия, которая конкурировала под именем Master. После ухода из соревновательной игры на смену AlphaGo Master пришла еще более мощная версия, известная как AlphaGo Zero, которая была полностью самоучкой, без изучения человеческих игр. Затем AlphaGo Zero был обобщен в программу, известную как AlphaZero, которая играла в дополнительные игры, включая шахматы и сёги. На смену AlphaZero, в свою очередь, пришла программа, известная как MuZero, которая учится без обучения правилам.

AlphaGo и его последователи используют алгоритм поиска по дереву Монте-Карло для поиска своих ходов на основе знаний, ранее полученных с помощью машинного обучения, в частности с помощью искусственной нейронной сети. сеть (метод глубокого обучения ) путем обширного обучения, как на людях, так и на компьютере. Нейронная сеть обучена определять лучшие ходы и процент выигрыша этих ходов. Эта нейронная сеть улучшает поиск по дереву, что приводит к более сильному выбору хода в следующей итерации.

В октябре 2015 года, в матче против Фань Хуэй, оригинальная AlphaGo стала первой компьютерной программой Go, которая победила человека профессионального игрока в го без гандикапа на полноразмерной доске 19 × 19. В марте 2016 года он победил Ли Седола в матче из пяти игр, впервые компьютерная программа Го обыграла 9-дан профессионала без гандикапа. Хотя он проиграл Ли Седолу в четвертой игре, Ли подал в отставку в последней игре, дав окончательный счет 4 игры против 1 в пользу AlphaGo. В знак признания победы AlphaGo была удостоена почетного 9 дан от Корейской ассоциации бадук. Подготовка и испытательный матч с Ли Седолом были задокументированы в документальном фильме, также озаглавленном AlphaGo, снятом Грегом Кохом. Он был выбран Science как один из призеров Прорыв года 22 декабря 2016 года.

На саммите Future of Go в 2017 году, Мастер версия AlphaGo победила Кэ Джи, игрока номер один в мире на тот момент, в матче из трех игр, после который AlphaGo был удостоен профессионального 9-го дана Китайской ассоциацией Weiqi.

После матча между AlphaGo и Ke Jie DeepMind удалил AlphaGo, продолжив исследования ИИ в других областях. Самоучка AlphaGo Zero одержала 100–0 побед над ранней соревновательной версией AlphaGo, а его преемник AlphaZero в настоящее время считается лучшим игроком в мире в го, а также, возможно, в шахматах.

Содержание

- 1 История

- 1.1 Матч против Фан Хуэй

- 1.2 Матч против Ли Седола

- 1.3 Шестьдесят онлайн-игр

- 1.4 Future of Go Summit

- 1.5 AlphaGo Zero и AlphaZero

- 1.6 Обучающий инструмент

- 2 версии

- 3 Алгоритм

- 4 Стиль игры

- 5 Ответы на победу в 2016 году

- 5.1 AI-сообщество

- 5.2 Go-сообщество

- 6 Подобные системы

- 7 Пример игры

- 8 Воздействие на го

- 9 См. Также

- 10 Ссылки

- 11 Внешние ссылки

История

Считается, что для компьютеров выиграть в го намного сложнее, чем в других подобных играх как chess, потому что его гораздо больший коэффициент ветвления чрезмерно затрудняет использование традиционных методов ИИ, таких как альфа-бета-обрезка, обход дерева и эвристический поиск.

Спустя почти два десятилетия после того, как компьютер IBM Deep Blue победил чемпиона мира по шахматам Гарри Каспарова в матче 1997 года, сильнейшие программы Go использовали Техники искусственного интеллекта достигли только уровня любительского 5 дан и все равно не смогли победить профессионального игрока в го без гандикапа. В 2012 году программа Zen, работающая на кластере из четырех компьютеров, дважды обошла Масаки Такемия (9p ) с гандикапом в пять и четыре камня. В 2013 году Crazy Stone победил Йошио Исида (9 очков) с гандикапом в четыре камня.

Согласно DeepMind Дэвиду Сильверу, AlphaGo Исследовательский проект был сформирован примерно в 2014 году, чтобы проверить, насколько хорошо нейронная сеть, использующая глубокое обучение, может конкурировать на Go. AlphaGo представляет собой значительное улучшение по сравнению с предыдущими программами Go. В 500 играх против других доступных программ Го, включая Crazy Stone и Zen, AlphaGo, запущенная на одном компьютере, выиграла все, кроме одной. В аналогичном матче AlphaGo, запущенная на нескольких компьютерах, выиграла все 500 игр, сыгранных против других программ Go, и 77% игр, сыгранных против AlphaGo, запущенной на одном компьютере. В распределенной версии в октябре 2015 года использовалось 1202 CPU и 176 GPU.

Match против Fan Hui

В октябре 2015 года распределенная версия AlphaGo победила европейцев. Чемпион го Фань Хуэй, 2 дан (из 9 возможных) профессионал, пять к нулю. Это был первый раз, когда компьютерная программа Го обыграла профессионального игрока-человека на полноразмерной доске без гандикапа. Объявление новости было отложено до 27 января 2016 года, чтобы совпасть с публикацией в журнале Nature статьи с описанием используемых алгоритмов.

Матч против Ли Седола

AlphaGo играл за профессионального игрока в го из Южной Кореи Ли Седола, занявшего 9 дан, одного из лучших игроков в го, пять игр проходили в Four Seasons Hotel в Сеуле., Южная Корея, 9, 10, 12, 13 и 15 марта 2016 г., которые транслировались в прямом эфире. Из пяти игр AlphaGo выиграл четыре игры, а Ли выиграл четвертую игру, что сделало его единственным игроком-человеком, который победил AlphaGo во всех 74 официальных играх. AlphaGo работает на облачных вычислениях Google, а его серверы расположены в США. В матче использовались китайские правила с 7,5-балльной коми, и у каждой стороны было два часа времени на размышления плюс три 60-секундных бёёми периода. Версия AlphaGo, играющая против Ли, использовала такое же количество вычислительной мощности, как и в матче с Fan Hui. The Economist сообщил, что в ней использовалось 1920 процессоров и 280 графических процессоров. На момент игры Ли Седол был вторым по количеству побед на международных чемпионатах по го в мире после южнокорейского игрока Ли Чанхо, который удерживал титул чемпиона мира в течение 16 лет. Поскольку не существует единого официального метода ранжирования в международном рейтинге Go, рейтинг может варьироваться в зависимости от источника. Хотя иногда он и занимал первое место, некоторые источники оценивали Ли Седола как четвертого лучшего игрока в мире в то время. AlphaGo не был специально обучен противостоять Ли и не предназначался для конкуренции с какими-либо конкретными игроками-людьми.

Первые три игры были выиграны AlphaGo после отставки Ли. Однако Ли обыграл AlphaGo в четвертой игре, выиграв отставкой на 180-м ходу. AlphaGo затем продолжил одерживать четвертую победу, выиграв пятую игру отставкой.

Приз составил 1 миллион долларов США. Поскольку AlphaGo выиграла четыре из пяти и, соответственно, серию, приз будет передан благотворительным организациям, в том числе UNICEF. Ли Седол получил 150 000 долларов за участие во всех пяти играх и дополнительно 20 000 долларов за победу в игре 4.

В июне 2016 года на презентации, проведенной в университете в Нидерландах, Аджа Хуанг, один из Глубинных людей. команда, выяснила, что они устранили логическую слабость, которая возникла во время 4-й игры матча между AlphaGo и Ли, и что после 78-го хода (который многие профессионалы назвали «божественным ходом »), он сыграет так, как задумано, и сохранит преимущество черных. До 78-го хода AlphaGo лидировала на протяжении всей игры, но из-за действия Ли вычислительные мощности программы были отвлечены и запутаны. Хуанг объяснил, что политическая сеть AlphaGo по нахождению наиболее точного порядка ходов и продолжения не совсем точно указала AlphaGo на правильное продолжение после 78-го хода, поскольку его сеть ценностей не определила 78-й ход Ли как наиболее вероятный и, следовательно, время, когда это движение была сделана AlphaGo не смогла внести правильную корректировку в логическое продолжение.

Шестьдесят онлайн-игр

29 декабря 2016 года на сервере Tygem появилась новая учетная запись с именем «Magister» «(обозначенный как Magist в китайской версии сервера) из Южной Кореи начал играть в игры с профессиональными игроками. Он изменил свое имя учетной записи на «Мастер» 30 декабря, а затем переместился на сервер FoxGo 1 января 2017 года. 4 января DeepMind подтвердил, что «Магистр» и «Мастер» игрались обновленной версией AlphaGo, называется AlphaGo Master. По состоянию на 5 января 2017 года онлайн-рекорд AlphaGo Master составлял 60 побед и 0 поражений, в том числе три победы над одним из лучших игроков Го, Кэ Джи, которого заранее незаметно проинформировали, что Мастер является версией AlphaGo.. После проигрыша Мастеру Гу Ли предложил награду в размере 100000 юаней (14 400 долларов США) за первого игрока-человека, который смог победить Мастера. Мастер играл в темпе по 10 партий в день. Многие быстро заподозрили, что это ИИ-игрок из-за того, что между играми почти не отдыхали. Среди его противников было много чемпионов мира, таких как Кэ Джи, Пак Чон Хван, Юта Ияма, Туо Цзяси, Ми Юйтин, Ши Юэ, Чэнь Яое, Ли Циньчэн, Гу Ли, Чан Хао, Тан Вэйсин, Фань Тиню, Чжоу Жуйян, Цзян Вэйцзе, Чжоу Чун-сюнь, Ким Джи-сок, Кан Дон Юн, Пак Ён Хун и Вон Сон Чжин ; национальные чемпионы или занявшие второе место на чемпионатах мира, такие как Лянь Сяо, Тан Сяо, Мэн Тейлин, Данг Ифэй, Хуан Юнсун, Ян Динсинь, Гу Цзихао, Шин Джинсео, Чо Хан Сын и Ан Сонджун. Все 60 игр, кроме одной, были быстрыми играми с тремя играми по 20 или 30 секунд byo-yomi. Учитель предложил продлить байо-ёми до одной минуты, играя с Не Вэйпином, учитывая его возраст. После победы в 59-й игре Мастер обнаружил себя в чате, которым управляет доктор Аджа Хуанг из команды DeepMind, затем сменил национальность на Соединенное Королевство. После того, как эти игры были завершены, соучредитель Google DeepMind, Демис Хассабис, сказал в твите: «Мы с нетерпением ждем возможности сыграть в некоторые официальные полнометражные игры позже [2017] в сотрудничестве с Организации и эксперты го «.

Эксперты в го были впечатлены производительностью программы и ее нечеловеческим стилем игры; Кэ Цзе заявил, что «после того, как человечество потратило тысячи лет на улучшение своей тактики, компьютеры говорят нам, что люди полностью неправы… Я бы сказал, что ни один человек не коснулся края истины Го». 314>

Future of Go Summit

На саммите Future of Go, проходившем в Wuzhen в мае 2017 года, AlphaGo Master сыграл три игры с Кэ Джи, Игрок, занявший первое место в мире, а также две игры с участием нескольких ведущих китайских профессионалов, одна парная игра в го и одна против совместной команды из пяти игроков.

Google DeepMind предложила троим призы победителями в размере 1,5 миллиона долларов. -игровой матч между Кэ Цзе и Мастером проигравшей стороны взял 300 000 долларов. Мастер выиграл все три игры у Ке Цзе, после чего AlphaGo была удостоена 9-го профессионального дана китайской ассоциацией Weiqi.

После победы в трехматчевом матче против Ke Jie, лучшего мирового игрока в го, AlphaGo в отставке. DeepMind также распустил команду, которая работала над игрой, чтобы сосредоточиться на исследованиях ИИ в других областях. После Саммита Deepmind опубликовала 50 полноформатных матчей AlphaGo vs AlphaGo в качестве подарка сообществу Go.

AlphaGo Zero и AlphaZero

Команда AlphaGo опубликовала статью в журнале Nature 19 октября 2017 года представляет AlphaGo Zero, версию без человеческих данных и более сильную, чем любая предыдущая версия, побеждающая человека-чемпиона. Играя в игры против самого себя, AlphaGo Zero превзошла по силе AlphaGo Lee за три дня, выиграв 100 игр с 0, достигла уровня AlphaGo Master за 21 день и превзошла все старые версии за 40 дней.

В статье, опубликованной на arXiv 5 декабря 2017 года, DeepMind заявила, что обобщила подход AlphaGo Zero в единый алгоритм AlphaZero, который за 24 часа достиг сверхчеловеческого уровень игры в играх шахматы, сёги и Go, победив программы чемпионов мира, Stockfish, Elmo и трехдневная версия AlphaGo Zero в каждом случае.

Обучающий инструмент

11 декабря 2017 года DeepMind выпустила обучающий инструмент AlphaGo на своем веб-сайте для анализа показателей выигрыша различных Проходы на ходу, рассчитанные с помощью AlphaGo Master. Инструмент обучения собирает 6000 открытий Го из 230 000 игр для людей, каждая из которых проанализирована с помощью 10 000 000 симуляций AlphaGo Master. Многие из открытий включают предложения о перемещении человека.

Версии

Ранняя версия AlphaGo была протестирована на оборудовании с различным количеством процессоров и графических процессоров, работающий в асинхронном или распределенном режиме. Каждому ходу давалось две секунды на обдумывание. Полученные рейтинги Эло перечислены ниже. В матчах с большим количеством времени на ход достигаются более высокие рейтинги.

| Конфигурация | Поиск. нитей | No. CPU | No. графических процессоров | рейтинг Эло |

|---|---|---|---|---|

| одиночный | 40 | 48 | 1 | 2,181 |

| одиночный | 40 | 48 | 2 | 2,738 |

| одиночный | 40 | 48 | 4 | 2,850 |

| одиночный | 40 | 48 | 8 | 2,890 |

| распределенный | 12 | 428 | 64 | 2,937 |

| Распределено | 24 | 764 | 112 | 3,079 |

| Распределено | 40 | 1,202 | 176 | 3,140 |

| Распределенный | 64 | 1,920 | 280 | 3168 |

В мае 2016 года Google представила собственное запатентованное оборудование «тензорные процессоры », которые, по ее словам, уже были задействованы в нескольких внутренних проектах Google, включая матч AlphaGo против Ли Седола.

На Future of Go Summit в мае 2017 года DeepMind сообщила, что версия AlphaGo, использованная на этом саммите был AlphaGo Master, и показал, что он измерял силу различных версий программного обеспечения. AlphaGo Lee, версия, использованная против Ли, могла дать AlphaGo Fan, версию, используемую в AlphaGo против Fan Hui, три камня, а AlphaGo Master был даже на три камня сильнее.

| Версии | Аппаратное обеспечение | Рейтинг Elo | Дата | Результаты |

|---|---|---|---|---|

| AlphaGo Fan | 176 Графические процессоры, распределенные | 3144 | октябрь 2015 г. | 5: 0 против Fan Hui |

| AlphaGo Lee | 48 TPU, распределенных | 3739 | март 2016 г. | 4: 1 против Ли Седол |

| AlphaGo Master | 4 TPU, одна машина | 4858 | май 2017 г. | 60: 0 против профессиональных игроков;. Future of Go Summit |

| AlphaGo Zero (40 блоков) | 4 TPU, одна машина | 5,185 | октябрь 2017 г. | 100: 0 против AlphaGo Lee

89:11 против AlphaGo Master |

| AlphaZero (20 блоков) | 4 TPU, одиночная машина | 5,018 | декабрь 2017 г. | 60:40 против AlphaGo Zero (20 блоков) |

Алгоритм

По состоянию на 2016 год алгоритм AlphaGo использует комбинацию методов машинного обучения и древовидного поиска в сочетании с обширным обучением, как на людях, так и на компьютере. Он использует поиск по дереву Монте-Карло, руководствуясь «сетью значений» и «сетью политик», которые реализованы с использованием технологии глубокой нейронной сети. Перед отправкой в нейронные сети ко входным данным применяется ограниченный объем предварительной обработки для определения особенностей игры (например, чтобы выделить, соответствует ли ход шаблону nakade ).

Нейронные сети системы изначально были созданы на основе человеческого опыта игры. AlphaGo изначально был обучен имитировать человеческую игру, пытаясь сопоставить движения опытных игроков из записанных исторических партий, используя базу данных, содержащую около 30 миллионов ходов. Когда он достиг определенной степени мастерства, он был дополнительно обучен, настроив играть большое количество игр против других экземпляров самого себя, используя обучение с подкреплением для улучшения своей игры. Чтобы избежать «неуважительной» траты времени оппонента, программа специально запрограммирована на уход в отставку, если ее оценка вероятности победы упадет ниже определенного порога; для матча с Ли порог отставки был установлен на уровне 20%.

Стиль игры

Тоби Мэннинг, судья матча AlphaGo vs. Fan Hui, описал стиль программы как » консервативный «. Стиль игры AlphaGo решительно отдает предпочтение большей вероятности выигрыша меньшим количеством очков по сравнению с меньшей вероятностью выигрыша большим количеством очков. Его стратегия максимизации вероятности выигрыша отличается от того, что обычно делают игроки-люди, а именно максимизируют территориальные выгоды, и объясняет некоторые из его странных ходов. Он делает много вводных ходов, которые никогда или редко делались людьми, при этом избегая многих вводных ходов второй линии, которые любят делать игроки-люди. Он любит использовать удары плечом, особенно если противник чрезмерно сконцентрирован.

Ответы на победу в 2016 году

AI-сообщество

Победа AlphaGo в марте 2016 года была важная веха в исследованиях искусственного интеллекта. Ранее Go считался серьезной проблемой в машинном обучении, которая, как ожидается, будет недоступна для технологий того времени. Большинство экспертов считали, что до такой мощной программы Go, как AlphaGo, осталось не менее пяти лет; некоторые эксперты считали, что потребуется еще как минимум десять лет, прежде чем компьютеры победят чемпионов го. Большинство наблюдателей в начале матчей 2016 года ожидали, что Ли победит AlphaGo.

В таких играх, как шашки (это было «решено » игроком в шашки Чинука team), шахматы, а теперь и го, выигранный компьютерами, победы в популярных настольных играх больше не могут служить важными вехами для искусственного интеллекта, как это было раньше. Deep Blue Мюррей Кэмпбелл назвал победу AlphaGo «концом эпохи… настольные игры более или менее сделаны, и пора двигаться дальше».